Google Guetzli - pliki JPEG mniejsze o 35 procent

Firma Google chwali się nowym algorytmem o nazwie Guetzli, który o 35 proc. może zmniejszyć rozmiar pliku JPEG bez utraty jego jakości.

Google wyjaśnia, że na proces kompresji obrazów JPEG składają się etapy polegające na transformacji przestrzeni barw, dyskretnej transformacji cosinusowej (DCT) oraz kwantyzacji. Algorytm Guetzli skupia się konkretnie na tym ostatnim etapie - poprawiając efekt końcowy, tak aby zachowana była równowaga pomiędzy jakością obrazu (ilością strat), a jego rozmiarem.

Announcing Guetzli, a new open source algorithm that creates high quality JPEG images with smaller file sizes https://t.co/beJ7d79jNk

— Google Research (@googleresearch) 16 marca 2017

Efektem ma być wspominana wcześniej redukcja wielkości pliku aż o 35 proc., bez widocznej utraty jakości obrazka, a co za tym idzie zmniejszenie ilości pobieranych danych oraz szybsze ładowanie grafik na stronach internetowych.

Szczegóły można znaleźć na Google Research Blog - tutaj.

fot. Unsplash, pixabay.com, CC0 Public Domain

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

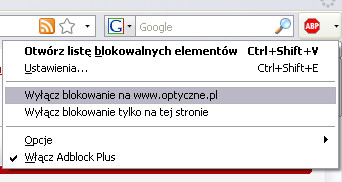

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

No oby... bo już tych wynalazków było miliony :)

Pozdrawiam

Tylko jakie to ma dziś znaczenie że jpg będzie 35% mniejszy? Przy dzisiejszych dyskach i transmisjach danych.

No jak jesteś flickrem czy googlem to ma duże znaczenie (liczone w milionach dolarów). Dla amerykanów też ma duże znaczenie, przy ich adopcji szybkiego internetu. A ja bym też się nie obraził o to, że moje jotpegi będą miały lepszą jakość.

@mokipera,

co do tego mają dyski i transmisje?

Ale to "już jest" jpeg2000 na falkach i jakoś się nie spopularyzowal. H265 też na falkach, AAC też na falkach. Falki średnio 2x lepsze od DTC. Plik zajmuje 2x mniej, a jakość ta sama

Nikogo nie interesują nasze dyski prywatne.

Problemem i kosztem są powierzchnie zajmowane przez chmury. Instagram, FB, itp itp. Tam każdy % mniej zajętego serwera i transmisji to konkretne pieniądze.

jakoś rok temu pojawiła się informacja o 2 miliardach zdjęć dziennie na FB tak a propo skali problemu.

A czemu rozwijają JPG? bo odczyta go wszystko :).

Ja też myślę, że niepotrzebnie kombinują. Zysk niewielki, a potem okaże się, że nowego formatu nie obsługuje akurat potrzebne nam oprogramowanie. No i pytanie czy w ogóle jest zysk, bo przy ściąganiu z sieci pewnie jest (mniej przesyłanych danych), ale przy przeglądaniu z dysku SSD może okazać się, że nowy algorytm jest wolniejszy i zdjęcie wolniej się wczytuje.

Ale jak ludzie zbojkotują to i tak format upadnie, nie raz już tak było :)

W opisie powinno być "transformacji kosinusowej", a nie "cosinusowej".

Szkoda, że BPG się nie przyjęło, a miało duże szanse - kodek (h265) w przeglądarkach internetowych jest już. link

@store10:

Te formaty na większą skalę nigdy się nie przyjmą. Z bardzo oczywistego powodu - są obarczone różnymi patentami i innymi problemami natury „własności intelektualnej“, co je w zasadzie dyskwalifikuje w starciu z nawet taką nędzą jaką jest JPG.

Algorytm JPG to kompresja stratna, więc jaki brak straty?

@TS

A jak mają zbojkotować jpeg? Przecież jeżeli zaadoptuje to np. Adobe to pliki eksportowane z LR czy Photoshopa będą w tym właśnie formacie (no chyba że będzie wybór).

Jeszcze jedno "a co za tym idzie zmniejszenie ilości pobieranych danych oraz szybsze ładowanie grafik na stronach internetowych." - tu nie chodzi o grafiki a o rastry. Wektory (SVG), które są dzisiaj standardem (strony responsywne) będą ładować się przecież tak samo. Sorry, że się czepiam, ale...

@ dell77

Ciekawe jak sobie radzi ten format z plikami o najniższym stopniu kompresji. Na tym przykładzie mamy tylko medium i small

JPG najdoskonalszym znanym standardem nie jest, opublikowano lepsze i sie nie przyjely.

Cos mi sie wydaje, ze Google na sile, z pozycji monopolisty, bedzie promowal nowy format i zarabial na licencjach zmuszajac producentow sprzetu i oprogramowania do ich nabywania.

Utrata jakości niestety jest. Nie ma nic za darmo.

Na tych samplach widać, że algorytm google wraz ze zmniejszeniem pliku zabrał ze sobą niektóre informacje o kolorze:

link

Dzieci drogie, dzieci... Czytanie ze zrozumieniem jednak jest niemodne.

@seboc: Przecież napisane jest, że algorytm jest open-source, więc jakie licencje?

@Wszyscy: to jest nowy algorytm generowania pliku JPG, a nie jakiś nowy format JPG. O ile nie trafi się na jakąś bombę, to powinien zdekompresować go dowolny dekoder plików JPG. Oczywiście w praktyce znajdzie się taki, który się na czymś wyłoży, ale wystarczy, że prawidłowo będzie to działać w przeglądarkach internetowych i wiodących aplikacjach (Adobe i reszta bandy). Mali się dostosują albo i nie. Zawsze jakiś bałaganik z formatami jest i nic tego nie zmieni.

@Wszyscy 2: Co do braku straty to oczywiście chodzi o porównanie do standardowej - owszem, stratnej - kompresji JPG, czyli jakość po kompresji jest porównywalna, a plik wynikowy mniejszy. W tym sensie brak straty, że w porównaniu do standardowego algorytmu.

Po co z nimi dyskutujesz ? Chcą zaistnieć, a mogą tylko hałasem.

@ komor

To nie jest wiedza tajemna, niedostępna dla nas szaraczków. Wystarczyło by dobrze przetłumaczyć to jedno krótkie zdanie "a new open source algorithm that creates high quality JPEG images with smaller file sizes" i by nie było mojej uwagi. Dobrze napisany artykuł charakteryzuje się logicznym i zgodnym z prawdą wyłożeniem zagadnienia. Right?

@ sektoid

Bo dyskusja to podstawowa forma komunikacji w naszym gatunku. Nawet jeśli się pisze pierdololo by zaistnieć, jak to zgrabnie ująłeś. Istotna jest jednak treść i siła przekazu

eeeetam... szanujacy sie fotograf nie zna pojecia jpg.;DDDDDD

Co za beznadziejny news, nie dosc ze mylacy to jeszcze zero istotnych informacji.

Po pierwsze zadna to rewolucja, bo adobe kompresuje z podobna efektywnoscia od lat.

Po drugie, kompresja google jest bardzo powolna i bardzo pamieciozerna - 10GB ramu i kilka minut zeby skompresowac 36mpix plik.

komisarz_ryba, na jakim procesorze masz ten komp z tymi 10 GB RAM? A moze 10 GB masz, ale HDD?

...super wiadomość dla wszystkich fotografujących komórkami z 200mp ..... i oglądających zdjęcia na ekranach 4cale, przykrytych plastikowym półprzezroczystym ochronnym ustrojstwem..... megapikseloza jest żałosna, nawet bardziej od megazoomomani...

No właśnie, nawet załóżmy, że każdy program będzie potrafił to odczytać i zapisać, to jednak działa wolniej. Przyznaję, że wcześniej nie doczytałem, ale to powinno się znaleźć w newsie, a nie że trzeba szperać po źródłach. W każdym razie jak przy eksporcie 100 plików czas kompresji wydłuży się tak jak pisze Google (teraz niech inni sobie doczytają ile ;p), to zysk na rozmiarze jest dla mnie zbyt mały. Ale może komuś się przyda.

Na dyskach to sobie panowie trzymamy RAW, JPG robi się do pokazywania w sieci.

Ktoś tam pisał o Flicker, akurat flicker to trzyma bełną jakość zdjęć, jaką można zrobić w JPG 100%

Google ma kłopot, nie mówiąc o FB. A dla osób wysyłających zdjęcia hurtem to w 99% nie ma znaczenia. Bo i tak są robione kamerką z przodu telefonu i tak są robione telefonem na połowę matrycy bo telefonem trzymanym w pionie i tak są rozmazane bo z toalety , windy czy klubu.

Takich śmieci jest najwięcej,

A Wyobraźcie sobie że od kilku lat, do serwerowni FB codziennie dostarczany jest nowy serwer dysków wielkości ogromnej szafy. A żeby to wszytko zasilić, FB serwerownia, ma taki sam dostęp to sieci energetycznej jak spora firma przemysłu ciężkiego. Już nie pamiętam ile tego biorą, ale spore odpowiednik sporego miasteczka. Zmnieszenie gufnianych fotosmieci to mniej dysków, to mniej prądu, przy takiej skali to ogromne oszczędności. FB i tak już kompresuje paskudnie zdjęcia :> nawet jak zaznaczysz wysyłkę HD to to zjecie gdy sciągnąć z powrotem na dysk to do niczego już się nie nadaje poza wysłaniem nazad na FB :)) I o to chodzi w tym całym zamieszaniu. Reszta kwestia kodowania i dekodowania to pikuś. Jak będą chcieli to są wstanie zrobic wtyczki, czy zaimplementować w aktualizacji i po sprawie. Wszytko zależy od tego jak bardzo będzie zalezało google na wprowadzeniu tego kompresora.

deel77, zawsze masz wybór w programach do jakiego formatu i jaki stopień kompresji ma być zastosowany, jeżeli dany format ma taką możliwość. Do wydruku stosuje się formaty bez stratne i w szerszej przestrzeni barw zazwyczaj Adobe, do wyświetlania na monitorach degraduje się do sRGB bo zapisując w kolorach Adobę co monitor to będą inne kolory i zapisuje się z kompresją jaka jest potrzebna. Zdjecia do galerii bez kompresji, a zdjęcia / grafiki poglądowe to nawet i 50% Bo po co więcej?

Nie wiem jak to dokładnie jest na fejsie, ale czy nie wystarczyłoby gdyby z automatu skalowali zdjęcia większe od, powiedzmy, FHD? Po co lepiej kompresować tony pustych pikseli...

Co do trzymania na dysku, to wszystkie zdjęcia jakie zrobiłem wywołuję do 1600 px na dłuższym boku (do niedawna brałem 1200), a jeśli mam tylko w jpg, to skaluję do tej rozdzielczości. Chodzi o to, by wygodnie i szybko przeglądać, pokazać znajomym, itp. Dlatego algorytm, który będzie mi to robił godzinami jest tylko kulą u nogi. Oczywiście wybrane do wydruków wywołuję w odpowiedniej rozdzielczości.

A poza tym co to za sztuka wymyślić algorytm, który policzy coś dokładniej, ale wolniej.

@cissic, cały patent właśnie na tym polega, że algorytm optymalizuje zdjęcie praktycznie bez utraty jego jakości, przy założeniu że pracujemy z domyślną wartością 95%. Testy które przeprowadzam wskazują, że nowy algo jest zarąbisty, można uzyskać zmniejszenie pliku nawet do 60%. Autorzy oszacowali, że 35%, moim zdaniem delikatnie mówiąc poszli asekuracyjnie. Jeśli do optymalizacji użyjemy dodatkowo Leanify można uzyskać zaskakujące wyniki.

PS. Dla Guetzli stworzyłem GUI na Windows, które ułatwia optymalizację:

link