Pentax K-3 II - zdjęcia przykładowe

Firma Ricoh udostępniła przykładowe zdjęcia wykonane zaprezentowaną niedawno lustrzanką Pentax K-3 II. W galerii znajdziecie 17 fotografii wykonanych tym aparatem. Wśród nich są zdjęcia zrobione przy użyciu funkcji „Pixel Shift Resolution System”, składającej cztery ekspozycje w jedno ujęcie.

Poniżej możecie oglądać przykładowe zdjęcia (udostępnione przez firmę Ricoh), wykonane aparatem Pentax K-3 II. Przypominamy, że model ten został wyposażony w matrycę APS-C CMOS o rozdzielczości 24 megapikseli, pozbawioną filtra AA, a także procesor PRIME III. Pentax K-3 II może fotografować z maksymalną czułością ISO 51200. Zastosowany został także układ SAFOX 11 z 27 punktami AF (25 punktów jest krzyżowych).

Aparat wyposażono również w technologię „Pixel Shift Resolution System”, polegającą na wykonaniu czterech ekspozycji, składanych potem w jedno zdjęcie. Dzięki temu każdy piksel zawiera pełne dane kolorów RGB, bez konieczności interpolacji, jak ma to miejsce w klasycznej siatce Bayera. Uzyskane tak zdjęcie ma charakteryzować się większą liczbą widocznych detali i lepszą kolorystyką.

M.in. przedostatnie zdjęcie w galerii wykonane zostało właśnie przy użyciu technologii „Pixel Shift Resolution System”. Z kolei ostatnia fotografia zawiera wycinki prezentujące fragment kadru - z włączoną oraz wyłączoną tą funkcją.

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

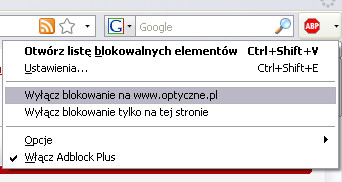

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Piąte od końca też wykonano przy użyciu pixel shifta.

Fajne.

Szkoda, że pokazują tylko na małych czułościach

@jaad75

Spotkałeś się może z informacją czy zewnętrzny O-GPS będzie działał z tym modelem czy jesteśmy skazani tylko na ten wbudowany?

Edzia86, nie spotkałem się, ale z drugiej strony, po co ktoś miałby w ten sposób tego używać? Ze względu na osobne zasilanie?

Podoba mi się ten "Pixel Shift Resolution System". Nareszcie widać jakiś postęp w odwzorowaniu.

Szkoda tylko, że póki co zastosowanie takie ograniczone - trzeba będzie naprawdę ultra szybkich matryc, żeby to zmienić...

... ale też / a może głównie / wydajnych procesorów do obróbki tego wszystkiego :)

Też, ale jeśli najnowocześniejsza w tej chwili 24MPix matryca Sony, czyli IMX271 pozwala ledwo na 19fps, czyli najkrótszy możliwy czas rejestracji takiego składaka wynosi ~1/5 s, to jesteśmy bardzo daleko od uniwersalności takiego rozwiązania... IMX193 z K-3II jest jeszcze wolniejsza i pozwala na rejestrację 4 zdjęć najkrócej w ~1/2 s...

W D8x0 trzeba skracać czas bardziej niż w 24mpix żeby nie poruszać zdjęć i nie tracić szczegółowości

więc dużo wody upłynie zanim będzie można robić wiele składowych fotek z ręki

choćby tylko z krótkimi obiektywami.

D8x0, czyli IMX094, to pixel pitch 4.9 um, IMX271, to 3.9 um - wymagania jednak nieco większe na APS-C... Poza tym, IMX094, to zaledwie w porywach 5fps, czyli składak z 4 klatek trwałby w okolicach sekundy... Żeby to miało użyteczność w normalnym zastosowaniu, to przydałoby się żeby całość rejestracji trwała jakąś 1/60 s, a to oznacza, że matryca i procesor musiałyby wyrabiać z 240fps przy pełnoklatkowym odczycie... Nie wiem czy doczekamy się takich matryc w najbliższych latach...

Pixel pitch nie ma tu nic do rzeczy.

Chodzi o to że na zdjęciach z aparatów z matrycami o mniejszej liczbie pikseli jest większa tolerancja poruszeń -nie widać ich efektów.

Z napitol... pikselami matrycy, jeśli chce się wykorzystać jej potencjał -trzeba bardziej skrócić czas.

Zdjecie tygrysa zrobione na ogniskowej 410mm- czy to znaczy, że niedługo ujrzymy również test 150-450?

@dcs, dla poruszeń, to właśnie pixel pitch jest istotny... tak jak i np. dla wielkości CA (w pikselach). Pomijając już, że obraz z wysokorozdzielczej matrycy wydrukowany w tym samym rozmiarze, co z niskorozdzielczej nie będzie miał widocznych poruszeń, mimo, że mogły być lekko widoczne na poziomie pikselowym.

@kojut, to są oficjalne zdjęcia ze strony Ricoh, a nie Optycznych - nie poznałeś po wyostrzaniu? :P

BTW, linkowałem je w komentarzach ponad tydzień temu. ;)

Contrast: Hard

Sharpness: Hard

Pięknie podostrzone fotografie.

wzrokowiec, było już, w zależności od zdjęcia są różne ustawienia - nie każdy czytnik exif pokazuje je prawidłowo:

link

tutaj widać, że to "hard" oznacza bardzo często co najwyżej 1 w skali od -4 do +4.

Będzie czad... rynek tego nie wytrzyma!!!

Te "co najwyżej 1" w skali -4 do +4, to "zaledwie" 5 w skali od 0 do 8. to takie kiepsko zakamuflowane mydełko :)

To 1 powyżej domyślnych ustawień, bądź domyślne ustawienia - niedużo, biorąc pod uwagę, że -4 oznacza tu całkowity brak wyostrzania.

Optyczni zresztą sami zalecali 0 jako optymalne ustawienie dla K-3:

"Zerowy stopień wyostrzania oferuje optymalne wydobycie detali (naszym zdaniem w szczególności dobrze prezentuje się opcja „precyzyjna ostrość”) i może być polecane dla osób korzystających wyłącznie z formatu JPEG i nie planujących dalszej obróbki zdjęć."

link

"to są oficjalne zdjęcia ze strony Ricoh"

Te z haczykami faktycznie już widziałem ;-)

Teraz dopiero oglądam te zdjęcia na komputerze: na ostatnim ujęciu widać nawet raster. Jest moc!

@jaad75, może wizja zdjęć w technologii pixel shift przy czasach rzędu 1/60 sek. lub krótszych nie jest wcale tak odległa jakby się mogło wydawać. Kto powiedział, że po każdym wykonanym zdjęciu trzeba od razu odczytywać całą matrycę? Może opracują sensor CMOS z pamięcią podręczną na trzy zdjęcia działający tak, że po wykonaniu pierwszego zdjęcia ładunki elektryczne z wszystkich fotodetektorów będą jednocześnie przepisywane do komórek pamięci podręcznej po czym będzie wykonywane kolejne zdjęcie. Po wykonaniu całej serii czterech zdjęć, zawartość matrycy i pamięci podręcznej będzie już na spokojnie sczytywana nawet przez te pół sekundy co już chyba nie będzie stanowiło jakiegoś wielkiego problemu. 24Mpix razy 3 zdjęcia to raptem 72 mln komórek pamięci. Dla obecnej technologii produkcji półprzewodników to raczej żaden problem.

@Grzenio - ładunek należy najpierw przetworzyć na informację, żeby zapisać go do pamięci podręcznej, czyli tak, czy inaczej trzeba sczytać matrycę. Chyba, że masz na myśli jakieś powiedzmy kondensatory, które pozwalałyby na przechowywanie go do późniejszego przetworzenia (z zachowaniem adresowania senseli), ale to chyba jednak większe science-fiction, niż ultraszybko czytane matryce, skoro już wkrótce będą na rynku sensory, które 8K są w stanie sczytywać 60fps (RED). Obecne Dragony, to zresztą 6K (czyli ponad 19MPix) przy 100fps, co pozwoliłoby 4 klatkowego składaka zarejestrować powiedzmy trochę dłużej niż 1/25s, a to już nie byłoby tak źle... Tyle tylko, że IMHO sporo czasu minie, zanim tak szybkie sensory stanieją na tyle by stosować je we w miarę dostępnych cenowo (w kategoriach aparatowych) sprzętach...

W UK cena k3ii preorder jest taka sama jak za k-3 w obecnej chwili. Cholera chyba wystawie swoje canony na ebayu ;)

@jaad75, oczywiście że chodziło mi o przepisanie samego ładunku do komórki pamięci a nie przetworzenie go na postać cyfrową 14 bitową i dopiero zapisanie w pamięci cyfrowej. To właśnie przetworzenie na postać cyfrową zajmuje najwięcej czasu więc trzeba to wykonać dopiero po wykonaniu czterech zdjęć. W większości pamięci półprzewodnikowych komórka pamięci to w zasadzie taki kondensator gromadzący ładunek. Te komórki pamięci podręcznej mogłyby być zlokalizowane bezpośrednio przy pikselach, podobnie jak tranzystory otwierające dostęp do odczytu danego piksela czy tranzystory resetujące jego ładunek wiec z zachowaniem adresowana nie powinno być problemu.

@Grzenio

Pomysł ciekawy, ale pewnie okazałoby się, że przez to matryca dużo bardziej się grzeje...

I nie jest to wcale jakiś science-fiction. To raczej odczyt 24-megapikselowej matrycy z prędkością 240fps jest jak na razie w zakresie marzeń. To jest 24 miliony ładunków zgromadzonych w pikselach, które po kolei trzeba wzmocnić, zmierzyć i przetworzyć na postać cyfrową. Łatwo policzyć, że potrzebny byłby do tego 14-bitowy przetwornik analogowo-cyfrowy o szybkości próbkowania 5,76 GSa/s albo kilka wolniejszych a to są jak na razie olbrzymie koszty. Myślę, że jakby Canon i Nikon mieli u siebie przesuwaną matrycę umożliwiającą pixel shifting to już dawno powstałyby takie matryce. Niestety jak na razie jest to niszowa technologia a zaprojektowanie i wdrożenie produkcji nowej matrycy to olbrzymi wydatek, który nieprędko się zwróci przy tak małym rynku odbiorców jak obecnie.

Co do nagrzewania matrycy to nie sądzę aby było większe podczas wykonywania zdjęć. Po pierwsze w tak krótkim czasie (1/60 sek) matryca nie zdąży się nagrzać bo ma pewną bezwładność termiczną. Po drugie nagrzewanie powoduje przełączanie tranzystorów z dużą częstotliwością a to odbywa się właśnie podczas odczytu kiedy trzeba zaadresować każdy piksel z osobna i odczytać jego ładunek.

@Grzenio "To raczej odczyt 24-megapikselowej matrycy z prędkością 240fps jest jak na razie w zakresie marzeń."

Patrząc na to co już dziś potrafi Red Dragon, czyli odczyt 19MPix matrycy przy 100fps i 16-bitach, to nie jest aż tak odległe marzenie, choć bez wątpienia nietanie. Przcież przy takim składaku nie trzeba też aż 16-bitowych RAW-ów, nawet 12-bit by wystarczyło, bo to i tak daje pełną 12 bitową informację RGB w każdym punkcie.

"Myślę, że jakby Canon i Nikon mieli u siebie przesuwaną matrycę umożliwiającą pixel shifting to już dawno powstałyby takie matryce. Niestety jak na razie jest to niszowa technologia a zaprojektowanie i wdrożenie produkcji nowej matrycy to olbrzymi wydatek, który nieprędko się zwróci przy tak małym rynku odbiorców jak obecnie. "

Póki co, to najwiecej w matryce inwestuje Sony, a oni stabilizację matrycową mają... Zresztą jak pokazuje przykład Hasselblada nie trzeba stabilizacji matrycowej, by poruszać matrycą - myślę, że jeśli Pixel Shift wzbudzi odpowiednio duże zainteresowanie, to NiC będą chcieli mieć podobną technologię u siebie. Tyle, że znowu, żeby wzbudzić duże zainteresowanie, potrzeba skrócić czas rejestracji... Zobaczymy co wymodzi Olympus, bo oni niby chcą skrócić rejestrację do wspomnianej 1/60s, choć nie wyobrażam sobie na razie tego przy ich 8-klatkowych składakach...

@jaad75, "Patrząc na to co już dziś potrafi Red Dragon, czyli odczyt 19MPix matrycy przy 100fps i 16-bitach, to nie jest aż tak odległe marzenie, choć bez wątpienia nietanie." Już dawno było możliwe tak szybkie przetwarzanie analogowo-cyfrowe ale cena takiego przetwornika (a w zasadzie kilku, bo jeden jest za wolny) jest niemała i nie tanieje w jakimś znacznym tempie. Raczej wątpię aby tak szybkie układy trafiły pod strzechy w niedalekim czasie. Poza tym to już wolę 14-bitową rozdzielczość RAW-ów niż 12 bitową i możliwość robienia zdjęć z pixel shiftingiem, który i tak ma bardzo ograniczony zakres zastosowań. Już w tej chwili dynamika tonalna w K-3 sięga prawie 13EV więc 12 bitowa rozdzielczość to trochę za mało aby to zmierzyć. Przepisanie ładunku z fotodetektora do komórki pamięci to na prawdę nie jest jakiś wielki problem. Zasada działania globalnej migawki elektronicznej właśnie polega na takim rozwiązaniu czyli ładunki z wszystkich fotodetektorów są jednocześnie przepisywane do takiej pamięci, z której później są piksel po pikselu odczytywane. Tutaj jest to opisane:

link

Nie wiem co za problem zrobić cztery komórki pamięci zamiast jednej i zapamiętywać w ten sposób cztery zdjęcia.

Pixel Shift najlepiej sprawdzi się do

odgrzania starych kotletów: .

Jego zastosowanie fotograficzne jest ograniczone do raptem kilku zastosowań.

Nawet krajobrazowa -gdzie są jakieś rośliny albo woda nie jest jednym z nich.

Dochodzi konieczność korzystania z krótkich czasów migawki.

Producenci Pentaksa i Olympusa użyli go żeby sprzedać K-3 II i E-M5 II -mało różniące się od poprzedników.

Po co zawracać sobie głowę jak tą technologię uczynić użyteczniejszą

jak efekt tych wydumek i tak będzie miał duże ograniczenia:

-maksymalnego czasu ekspozycji

-możliwości użycia trybu zdjęć seryjnych

...

Co z tego że może kiedyś zejdą do 1/60 s?

Jak już pisałem -jeśli chce się wykorzystać jej potencjał napakowanej matrycy konieczne jest skrócenie czasu. Dla D8x0 i obiektywu 50mm 1/30 sekundy -to nie jest czas zapewniający nieporuszenie.

dcs, kompletnie nie zrozumiałeś - chodzi o całkowity czas rejestracji 4 klatek z przesunięciem, tak, by minimalizowac artefakty wynikające z ewentualnego ruchu w kadrze 1/60 zapewnia już dość szeroką gamę zastosowań. Pojedyncze klatki mogą być rejestrowane z bardzo krótkim czasem naświetlania, to nie problem. A technologia jest jak najbardziej rozwojowa, bo skrócenie rejestracji może być wykorzystywane np. do wielokrotnego odczytu matrycy z różną ekspozycją - wcale nie trzeba ruszać matrycą w jej trakcie...

@dcs, rozwiązanie z pamięcią podręczną na cztery zdjęcia umożliwiłoby zejście do czasów 1/1000 albo i krócej. Ograniczeniem byłby tylko czas potrzebny na przesunięcie matrycy o 1 piksel i jej ustabilizowanie no i oczywiście czas naświetlania pojedynczego zdjęcia.

To ty nie rozumiesz.

Jeżeli ostatnie zdjęcie będzie rejestrowane po prawie 1/60 sekundy po pierwszym

(jak tu trąbią: że 1/60 da możliwość robienia z ręki)

będą przesunięte względem siebie o więcej niż 3.9 um ( czy ile tam) -czyli więcej niż przesuwa

„Pixel Shift Resolution System"

już przy użyciu lekko długich -portretowych obiektywów.

I większej szczegółowości nie będzie.

Przy 1/60 lekko kołyszące się na wietrze liście, trawa, płynąca woda -też nie będzie miała szczegółowości zdjęcia 40mpix (czy ile tam)

Tyle.

@dcs "Jeżeli ostatnie zdjęcie będzie rejestrowane po prawie 1/60 sekundy po pierwszym"

Po ~1/80 s, w przypadku składaka z 4 zdjęć.

"będą przesunięte względem siebie o więcej niż 3.9 um ( czy ile tam) -czyli więcej niż przesuwa

„Pixel Shift Resolution System"

już przy użyciu lekko długich -portretowych obiektywów."

Niekoniecznie, nie wszystko porusza się na tyle szybko.

"I większej szczegółowości nie będzie."

W przypadku szybko poruszających się obiektów - nie, przy w miarę stabilnych, już tak. Poza tym zapominasz, że każda ekspozycja ma pełną informację bayerowską, więc w przypadku wykrycia ruchu (a da się to robić niezbyt skomplikowanymi algorytmami, choćby przez proste porównanie), można by było lokalnie na mocno ruchomym obiekcie użyć tylko zdemozaikowanej informacji z jednej z tych czterech ekspozycji.

Teoretyczne możliwości są spore, a im całość rejestracji szybsza, tym większe - przy 1/2 s to raczej ciekawostka z niewielką liczbą, dość specyficznych zastosowań, ale przy 1/60s można by już tego używać całkiem serio.

"Niekoniecznie, nie wszystko porusza się na tyle szybko."

-"jak tu trąbią: że 1/60 da możliwość robienia z ręki" -Z RĘKI

"więc w przypadku wykrycia ruchu (a da się to robić niezbyt skomplikowanymi algorytmami, choćby przez proste porównanie), można by było lokalnie na mocno ruchomym obiekcie użyć tylko zdemozaikowanej informacji z jednej z tych czterech ekspozycji."

-"I większej szczegółowości nie będzie.

Przy 1/60 lekko kołyszące się na wietrze liście, trawa, płynąca woda -też nie będzie miała szczegółowości zdjęcia 40mpix (czy ile tam)"

kamienie, budynki ... będą miały detal jak z 40mpix,

a ruchome -nie. :-)

Więc to będzie "jak 40mpix" ale nie zupełnie.

Prawie 40mpix.

"Prawie robi różnicę"

Ja nie wiem, co Ty się tak tych 40MPix uczepiłeś, mnie chodzi akurat głównie o pełnokolorową informację w każdym punkcie (i ewentualnie HDR z takich np. 2-3 ekspozycji, które można by było zrobić jeszcze szybciej) - pogorszenie informacji o kolorze na szybciej poruszających się obiektach można IMHO przeboleć.

"mnie chodzi akurat głównie o pełnokolorową informację w każdym punkcie"

-po co to komu?

"(i ewentualnie HDR z takich np. 2-3 ekspozycji, które można by było zrobić jeszcze szybciej)"

-zmieniając czas ekspozycji?

(czy wartość przysłony)

Po co, 13EV dynamiki to za mało?

Prawie 40mpix Olympus E-M5 II link

link

link

a przepraszam,

Olympus E-M5 II w Hi Res

RAW ma 64 MPix

...i wcale tego nie widać :-))

dcs, a po co komu Foveon? Nie widzisz kolosalnej różnicy jakościowej zdjęć z Foveonów w niskich czułościach? Tutaj można by ją mieć opcjonalnie, a w trybie bayerowskim wciąż mieć dobre wysokie czułości, bo przecież pixel shift nie ogranicza w żaden sposób normalnej użyteczności aparatu. Poza tym, współczesne Foveony, to 3x15MPix, podczas gdy np. już dziś w trybie pixel shift można mieć w ograniczonym zastosowaniu odpowiednik Foveona 3x24MPix...

A co do dynamiki - przecież sceny przekraczejące 13EV nie są niczym niezwykłym, a do tego ostatnie dwa bity trudno nazwać w pełni użytecznymi - owszem giną w cieniach, ale jeśli jest taka potrzeba, to można by użyć trybu HDR pozbawionego w dużej mierze wiadomych wad tej techniki w tradycyjnym wykonaniu.

"Nie widzisz kolosalnej różnicy jakościowej zdjęć z Foveonów w niskich czułościach?"

-czym charakteryzuje się ta "jakość zdjęć z FeveronóW?

Jaja sobie robisz?

Nie. Napisz konkretne kategorie w których jest lepsza.

(oddanie kolorów, dynamika tonalna, rozdzielczość, ...)

Przejścia tonalne, zwłaszcza niskokontrastowe, monochromatyczne tekstury, detal na poziomie pikselowym... W sumie, przecież wystarczy popatrzeć, nie wiem co chcesz tym razem kwestionować, zwłaszcza, że nie wątpię, że zdjęcia z Foveonów widzialeś nie raz...

Zresztą powyżej też masz przykład zdjęcia z trybu foveonopodobnego i normalnego:

link

To równie dobrze mogłaby być ilustracja do tematu Foveon kontra Bayer.

"Przejścia tonalne, zwłaszcza niskokontrastowe"

-dynamiką (na bazowym) nie powala

ile tam w testach EV Foveony mają?

-oddanie kolorów nie najlepsze -lubi przesycać, ciężko ustawić do tablicy -naturalnego wszystkie naraz

"monochromatyczne tekstury, detal na poziomie pikselowym..."

-czyli rozdzielczość? -POTWIERDŹ lub ZAPRZECZ!

2700LWPH to żadna rewelka -tyle mają Nikony aps-c 24mpix bez AA (ok. 90 lpmm) i K-3

Rozdzielczość, ale w znacznie szerszym ujęciu niż MTF50 na czarnobiałej tablicy.

ale to załatwi odpowiednio więcej pikseli pod pierzynką Bayera :)

bez ograniczeń w: użytecznym ISO, maksymalnym czasie ekspozycji

...w (jakichś tam) możliwych zdjęciach seryjnych

...

i można robić z ręki :)

@dcs "ale to załatwi odpowiednio więcej pikseli pod pierzynką Bayera :)"

Owszem - do czasu. Z ograniczeniami w postaci ISO itd. bo przecież nie będzie można zwiększać rozdzielczości zupełnie bezkarnie, chyba, że za każdym razem producenci będą czekali aż technologia dojrzeje do kolejnego skoku rozdzielczościowego (w co wątpię). A i to do czasu.

Pixel shift będzie tu zawsze o krok do przodu z jakością, bo ta sama matryca będzie mogła zarejstrować pełną informację w każdym punkcie.

"Pixel shift będzie tu zawsze o krok do przodu z jakością, bo ta sama matryca będzie mogła zarejstrować pełną informację w każdym punkcie."

@jaad75

Gdzie to widać?

link

link

link

bo ja mam wrażenie, że 36mpix Nikona z Bayerem > niż 64mpix Olympusa E-M5 II z "pełną informację w każdym punkcie"

Tu:

link

Rozczarowujesz mnie. ;)

Jasne, że 16,544x12,400 pixeli

to więcej niż 8272 x 6200 pixeli.

Ja ci pokazuje, że 64mpix Pixel Shift Olympusa E-M5 II nie dorównuje szczegółowością 36mpix z Bayerem Nikona. Tylko ja to widzę?

Ja Ci pokazuję, że tryb Color działa - chodziło mi o środek vs lewa strona, a nie tryb 6-cio strzałowy. Jeśli chodzi o Olympusowe rozwiązanie, to lepiej wygląda mi w JPG, niż w RAW, być może Adobe też jeszcze nie do końca wie co robić z tymi plikami.

PEG (40 MPix) E-M5 II jest przeostrzony -ze wszystkimi tego konsekwencjami

także tymi złymi

No i JPEG 40 MPix wygląda lepiej niż RAW 64 MPix : D

Owszem jest przeostrzony, jak to JPG, ale odnoszę wrażenie, że na bazowym pliku było więcej niż na wersji Adobe, stąd wniosek, że być może Adobe jeszcze nie radzi sobie z tymi plikami optymalnie. Zauważ też co się dzieje w niektórych newralgicznych miejscach:

link

link

Hi Res JPEG i RAW

link

link

link

Optyczne zwalało na f/8

"Tutaj efekt „miękkości” obrazu w trybie Hi Res Mode jest nawet większy. Trzeba jednak mieć na uwadze, że zdjęcia scenki wykonujemy przy przysłonie f/8. Dla tej wartości obserwujemy większy wpływ dyfrakcji, która przy małych otworach względnych obiektywu skutecznie ogranicza zdolność rozdzielczą matrycy. " link

Dpreview zrobiło na f/4 (Panasonic Leica DG Nocticron 42.5 mm f/1.2 )

dcs, co jest nie tak że zdjęciami z Pentaxa? I po co wstawiasz linki do przykładowych zdjęć z Olka? To tak jakbyś chciał opowiedzieć o właściwościach 24mpix matrycy pentaxa na podstawie sampli z 16mpix matrycy olympusa.

@dcs, dla matrycy 4/3 jaka jest w Olympusie i przysłony 4.0 limit dyfrakcyjny jest osiągany dla rozdzielczości około 31Mpix. W przypadku Canona i Nikona mamy do czynienia z matrycą FF co przy przysłonie 5.6 daje limit dyfrakcyjny przy około 61Mpix. Także 50Mpix matryca Canona czy nawet 36Mpix matryca Nikona zapewniają lepszą rozdzielczość niż w przypadku zdjęć High Res z Olympusa gdzie ograniczeniem jest po prostu optyka i żadne multi shoty czy pixel shiftingi nic nie pomogą. Jaki zysk daje tryb Hi Res można zobaczyć porównując możliwości 16Mpix matrycy 4/3 z Olympusa do 24Mpix matryc APS-C bez trybu Hi Res:

link

4 zdjęcia ze statywu w łącznym czasie ekspozycji ··1 sekundy 16mpix Olympusem E-M5 II

żeby przegonić raptem matryce 24mpix (z dowolnym czasem ekspozycji, np. w zdjęciach seryjnych, BEZ ARTEFAKTÓW bez względu na tematykę) ???

"...w łącznym czasie [bez- ekspozycji] ··1 sekundy..."

^^^

to był 1.

2. "Także 50Mpix matryca Canona czy nawet 36Mpix matryca Nikona zapewniają lepszą rozdzielczość niż w przypadku zdjęć High Res z Olympusa gdzie ograniczeniem jest po prostu optyka i żadne multi shoty czy pixel shiftingi nic nie pomogą."

-to nie wina dyfrakcji, ani rozdzielczości (podobno) niezrównanie ostrych obiektywów do systemu m4/3,

że zdjęcia 40mpix z E-M5 II nie dorównują prawdziwym 36mpix.

@dcs, ja tylko podałem wytłumaczenie dla czego zdjęcie 64Mpix z Olympusa jest mniej ostre od 36Mpix zdjęcia z Nikona D810 czy 50Mpix zdjęcia z Canona 5DS R, które przytoczyłeś. Jeśli nie chcesz wierzyć, że to wina dyfrakcji to popatrz na ostatnią tabelkę na tej stronie:

link

albo policz sobie tym kalkulatorem:

link

Zastosowanie techniki pixel shift ma swoje ograniczenia ale jeśli niewielkim kosztem (sam software) producent dodał taką funkcję to nie mam nic przeciwko temu. Może czasem się przyda. Osobiście jednak uważam, że jak komuś zależy na ultra wielkiej rozdzielczości i fotografuje statyczne sceny to można posłużyć się równie dobrze a może nawet z lepszym efektem techniką składania gigapanoram z kilkudziesięciu zdjęć.

Najprostszym wytłumaczeniem tego, ze wygląda to jak wygląda jest to

że Hi Res sam w sobie działa słabo (RAW) -poza detalem w kolorach

a większy wpływ na wow! -efekt ma wyostrzanie w jpeg. -stąd te różnice w odbiorze dwu formatów

Czyli materiał bazowy -składak Raw Pixel Shift- jest... taki sobie, ale podostrzony (mocno przeostrzony mz) pokazuje wyższość nad Bayerem

Grzenio, a co ma limit dyfrakcyjny do składaka? Limit dyfrakcyjny tyczy się jednego zdjęcia, złożenie kilku zdjęć z przesunięciem pikselowym ten limit obchodzi - nie można obliczać limitu dyfrakcyjnego dla składaka, tak, jak liczy się go dla matrycy o konkretnej rozdzielczości.

dcs, Olympus składa 8 zdjęć, nie 4.

Najprostszym i zarazem słusznym wytłumaczeniem dla przytoczonych przez Ciebie przykładów jest zjawisko dyfrakcji. Zauważ, że limit 31Mpix dla optyki Olympusa domkniętej do F4.0 dotyczy światła zielonego. Dla czerwonego jest to już tylko 21Mpix. Poza tym nie jest to 31Mpix ostrych jak brzytwa pikseli tylko limit rozdzielczości gdzie można jeszcze rozróżnić dwie sąsiednie linie. Aby obraz był ostry i kontrastowy optyka powinna mieć jeszcze wyżej położony limit dyfrakcyjny. Zobacz na pierwszą tabelkę z tej strony: link Dla MTF 80% przy przysłonie 4.0 otrzymujemy max. rozdzielczość optyczną 73lp/mm co przy matrycy z Olympusa wysokiej na 13mm daje nam max. 1898 LW/PH z dobrym kontrastem. To jest rozdzielczość optyczna ograniczona dyfrakcją a gdzie jeszcze rozmycie obrazu z uwagi na aberracje sferyczne, chromatyczne, astygmatyzm i błąd w ustawieniu ostrości?

Tryb Hi Res nie działa słabo. Działa bardzo dobrze. Likwiduje w 100% kolorową morę, która bardzie psuje obraz niż lekka nieostrość i jest widoczna nawet na tych ostrzejszych zdjęciach z Nikona D810 czy Canona 5DS R., które podałeś za przykład: link

@jaad75, limit dyfrakcyjny dotyczy limitu rozdzielczości optycznej obiektywu. Możesz sobie przesuwać matrycę nawet co 1/100 piksela i składać zdjęcia a i tak nie zobaczysz większej rozdzielczości bo po prostu obraz padający na matrycę będzie nieostry. To tak jakbyś źle ustawił ostrość - nic już nie poprawisz samym przesuwaniem matrycy. Możesz sobie składać zdjęcie nawet z setek zdjęć ale ostrości nie poprawisz. Piksel shifting symuluje tylko efekt jaki uzyskalibyśmy przy matrycy o większej gęstości ale nigdy nie poprawi optyki obiektywu.

Nie, limit dyfrakcyjny tyczy się, jak sama nazwa wskazuje, zjawiska dyfrakcji światła na przysłonie obiektywu. Dla składaka z 4 ekspozycji z przesunięciem pikselowym jest taki sam, jak dla pojedynczej ekspozycji, w przypadku przesunięć o 1/2 piksela, również każda pojedyńcza ekspozycja jest ograniczona takim samym limitem.

Moża uzyskać znacznie większe rozdzielczości metodą uśredniania serii kilkunastu - kilkudziesięciu ekspozycji losowo przesuniętych naturalnym drżeniem ręki - oczywiście krawędź trzeba będzie sztucznie wzmocnić, ale detali będzie widocznych więcej.

tyle że to nic nowego link

Oczywiście, że nic nowego. :)

@Jaad75, niby dobrze piszesz o limicie dyfrakcyjnym ale wnioski wyciągasz błędne. Dyfrakcja powoduje ograniczenie rozdzielczości optycznej obiektywu i zmniejszenie szczegółowości obrazu padającego ma matrycę. Robienie kilkunastu zdjęć z mikroprzesunięciem niczego tutaj nie poprawi bo po prostu tych szczegółów już nie ma po przejściu przez układ optyczny. Poczytajcie co to takiego plamka Airy'ego: link

Owszem technika robienia wielu zdjęć z mikroprzesunięciem nie jest żadną nowością. Powiem więcej, była znana i stosowana znacznie wcześniej niż powstał pierwszy cyfrowy aparat fotograficzny a dokładniej wykorzystywana była w elektronice przy tzw. próbkowaniu ekwiwalentnym kiedy za pomocą przetwornika o niewielkiej szybkości próbkowania można było próbkować sygnały o częstotliwości znacznie większej od częstotliwości Nyquista. Tak się składa, że analogicznie rozdzielczość matrycy można porównać do częstotliwości próbkowania a szczegółowość obrazu do częstotliwości sygnału. Jak sygnał przepuścimy przez filtr dolnoprzepustowy to na nic się nam przyda większa częstotliwość próbkowania bo i tak w sygnale nie ma już składowych o wyższej częstotliwości.

Robienie serii zdjęć, czy to chaotycznie przesuniętych czy precyzyjnie o 1/2 piksela, ma na celu tylko zasymulowanie jak by wyglądało zdjęcie zrobione przy większej rozdzielczości matrycy. Można sobie wyobrazić sytuację kiedy obraz padający na matrycę składa się z naprzemiennych czarny i białych linii o szerokości dokładnie jednego piksela. Jak obraz ten ułoży się tak, że biała linia będzie zajmowała pół jednego piksela i pół sąsiedniego to oba piksele zmierzą takie same natężenie światła równe 50%. W rezultacie otrzymamy zupełnie gładki obraz o 50% szarości, pozbawiony jakichkolwiek linii. Wystarczy teraz, że przesuniemy matrycę o pół piksela a uzyskamy nagle kontrastowy obraz naprzemiennych czarnych i białych linii. Co będzie jak teraz uśrednimy te dwa zdjęcia, czyli gładki obraz o 50% szarości i kontrastowe czarno-białe pasy? A no uzyskamy wypadkowy obraz szarych pasów o natężeniu 25% i 75%. W rezultacie dostaniemy 100% pewności, ze na takim obrazie zobaczymy pasy. Przy jednym wykonanym zdjęciu różnie to może być albo będziemy mieli obraz pasów albo nie. Na tym właśnie polega technika którą przytaczacie. Tylko, że ja nadal nie wiem w jaki cudowny sposób ma to zlikwidować rozmycie obrazu w wyniku dyfrakcji? Limit dyfrakcyjny wyrażony w Mpix jest tylko informacją, że nie ma sensu zwiększanie rozdzielczości ponad te "X" Mpix bo i tak obraz padający na matrycę będzie pozbawiony szczegółów.