Canon EOS R3 w naszych rękach

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

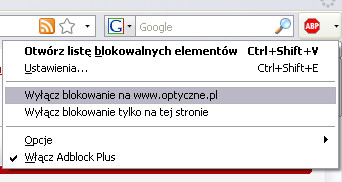

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Będziemy wdzięczni, jeśli dodasz stronę Optyczne.pl do wyjątków w filtrze blokującym reklamy.

Z góry dziękujemy za zrozumienie.

Kliknij tutaj aby zamknąć to okno.

Komunikat nie wyświetli się więcej podczas tej sesji (wymagana obsługa cookies).

Trochę mnie niepokoi niepewne działanie Eye Control AF - ale też mam nadzieję, że to kwestia właściwej kalibracji (czy w języku AI: nauczenia się użytkownika).

Maszyna i nie ma to tamto. Cena :D

Cena choć wysoka to jest lepiej niż przy Sony A1 - spodziewałem się, że Canon poszaleje. Pomijając cenę to może to być bardzo udany sprzęt.

Ten obiektyw 16 mm ciekawy. Mały, lekki idealny w podróż. Patrząc na system RF może być przyzwoitej jakości w tej cenie.

Eye control było także w eosie 5. Wiem, bo miałem. Działało to bardzo dobrze i pewnie, mimo że było to tylko pięć sensorów w poziomie. Potem dziwiło mnie, że ta technologia została na lata zarzucona przez producentów, mimo że już się sprawdziła w praktyce.

Tego eosa 5 wspominam miło też i z tego powodu, że był bardzo cichy, jak na standardy lustrzankowe. No, to sobie weteran powspominał.

A ten aparat całkiem interesujący. Bryła fajna, możliwości spore.

Ciekaw jestem, jak wyjdzie matryca w testach.

Westberg - ktoś mi kiedyś tłumaczył, że ówczesna wersja skanowała oko laserem (odpowiednio małej mocy, oczywiście) i nie było pewności, czy to będzie bezpieczne z medycznego i "prawniczego" punktu widzenia.

Nie wiem, czy to prawda, ale brzmiało (i brzmi) sensownie. Teraz gaze-tracking można zrobić już "w świetle zastanym".

Czy ja co przegapiłem , czy rzeczywiście nie ma informacji o zakresie czułości?

@baron13 - masz specyfikację w bazie, wystarczy kliknąć. 100-102400, rozszerzalne do 50-204800

Taki drogi?! Mam nadzieję, że chociaż torba będzie w zestawie.

Kalibrację robiliście w okularach czy bez?

Ciekawe kiedy Optyczni nauczą się prawidłowo używać cudzysłowu. Bo szastają nimi na lewo i prawo, bez sensu, bez opamiętania.

@westberg - EOS-5 był cichy bo jego napęd był na pasku gumowym, dlatego teraz z tymi aparatami mogą być problemy, wiadomo paski z wiekiem się degradują.

Jeśli chodzi o Eye Control to kiedyś słyszałem że Canon złamał jakiś patent firmy Honeywell bodajże i w wyniku ugody musiał zrezygnować ze stosowania systemu, nie wiem ile w tym prawdy i jak sobie z tym teraz poradzili.

Miałem EOSa-3 z tym systemem i nie specjalnie go używałem.

mam do dzisiaj 5d z tym e-control -a paratu nie uzywam od lat choc jest sprawny.

bylo to malo przydatne.

dzialalo zawsze idealnie , gdy sie robilo testy , w trakcie powazniejszego fotografowania potrafilo sie przestawic nie tam gdzie trzeba.

spowalnialo tez prace AF , wyczuwalne bylo opoznienie jakby na namysl. Tak ze specjalnie tego nie oczekuje , nawet gdyby mialo lepiej dzialac. Na szczescie mozna to odlaczyc.

to gadget robiacy wrazenie na gimbazie.

@deel77: „Cena choć wysoka to jest lepiej niż przy Sony A1”

– to teraz pomyśl, ile będzie kosztował R1, kiedy go zrobią… :)

@Pokoradlasztuki: „bylo to malo przydatne”

– może po prostu nie potrafiłeś tego używać?

@Pokoradlasztuki

Ale ze jak to 5d ??

@Amadi: dzięki, kliknąłem :-)

Jeśli Andrew Reid (EOSHD) ma rację:

link

to "umarł król, .........nich żyje król"

Premiera "mojego" aparatu już się odbyła i nie stało się dziś nic, co w najmniejszym stopniu odwróciłoby moja uwagę od GFX50SII, choć oczywiście te aparaty zaspokajają zupełnie inne potrzeby.

Czekam również na kwantowy skok w wykonaniu OM DS i po pełna klatkę sięgnę tylko w wersji Monochrom..

Na Youtubie w review Gordon Lainga R3 nagrywał do 6 godzin podpięty do zasilania USB-C. Fajna jest ta opcja zapisu filmu 6K DCI, to pozwala celować w docelowy materiał 4K z opcją dokadrowania lub dodatkowej stabilizacji.

Różnymi mykami swojego R3 Canon się chwali, ale Wreszcie Normalnym Sposobem ustawiania WB wg wzorca, już nie. W sumie to mu się nie dziwię. Napomknie o tym pewnie dopiero przy premierze następcy RP. Że niby amatorski model, a ma rozwiązania takie jak flagowiec.

komor

z całym szacunkiem. ale w dniu prezentacji apartu materiały na yt, to tuba wzmacniająca informacyjny szum...a nie źródło informacji, .

@molon_labe, z całym szacunkiem, ale nie wiesz, o czym piszesz. :) Na YT jest sporo wiarygodnych twórców. W tym fotografów, którzy dostają przed premierą aparaty od producentów. Gordon Laing pierwszy film pokazujący R3 wrzucił 3 miesiące temu, czyli już wtedy dostał przedprodukcyjny egzemplarz od Canon UK. Teraz, po premierze, masz prawie pełne review foto i wideo. Z materiałami, tablicą testową itd. Warto obejrzeć.

@molon_labe

Podałeś link do starej plotki, która została zdementowana przez Canona długo przed premierą. Poza tym rozdzielczość się nie zgadza, więc to nie może być ta matryca.

komor

Jeśli ręczysz za Gordona, że się nigdy nie "zeszmacił", to materiał obejrzę..

Więc jak?

@molon_labe: jest chyba łatwo po latach, dekadach wręcz, ew przypadku camera labs i Gordona, wyrobić sobie zdanie na temat subiektywizmu i preferencji autora recenzji.

dla mnie kryterium jakości recenzji jest proporcja suchych danych i monotonnych opisów funkcji i jak to w praktyce działa, do marketingowych obietnic i gdybania.

ryszardo

Znam wszystkie (chyba) wszystkie relacje na ten temat, co kto oświadczał i w odpowiedzi na co.

Nie o ilość pixeli tu chodzi, a o technologię BSI, która jest rozwiązaniem Sony,

Patenty Canona dotyczyły innych kwestii, jak np: odprowadzenie ciepła

link

Podawana ilość pixeli nie ma tu znaczenia. Jeśli ktoś, poza Sony, używa nazwy BSI w "swoich" sensorach, to znaczy, że nabył do niej prawo. Słowo klucz to "nabył"

ryszardo

O! tego szukałem:

link

Oczywiście sensor to "wierzchołek góry lodowej" Ważne jest oprogramowanie, przetwarzanie kolorów i wiele innych rzeczy, o których ...wielu ojców patentów napisało.

Ale matka technologii BSI, jak mówi łacińska sentencja, jest tylko jedna

BSI to skrót nazwy technologii, która jest starsza od jakichkolwiek aparatów cyfrowych z matrycami tego typu.

Używanie tej nazwy nie oznacza absolutnie nic w kontekście zakupu technologii, ponieważ Sony nie ma do nazwy żadnych praw. Nikt nie ma.

ryszardo

.....te bardzo jednoznaczne twierdzenia, mają jakieś źródłowe podstawy, czy tylko ambicja każe Ci je formułować?

Cichy14 września 2021, 17:30

@Pokoradlasztuki

Ale ze jak to 5d ??

-

nie to eos 5

"d" to z rozpedu , dzisiaj wydaje sie rownie archaiczny.

f-nieobiektywny: "Różnymi mykami swojego R3 Canon się chwali, ale Wreszcie Normalnym Sposobem ustawiania WB wg wzorca, już nie."

W 1D Mk III można zrobić zdjęcie kartki [ link - str. 64] - to o taki sposób chodzi?

komor14 września 2021, 17:24

@deel77: „Cena choć wysoka to jest lepiej niż przy Sony A1”

– to teraz pomyśl, ile będzie kosztował R1, kiedy go zrobią… :)

@Pokoradlasztuki: „bylo to malo przydatne”

– może po prostu nie potrafiłeś tego używać?

-----

a co to ma wspolnego z moimi umiejetnosciami , skoro obslugujac w ten sam sposob aktywacja EC spowalniala wyczuwalnie prace AF?

problem polega na tym , ze kontrolujac kadr, af wbrew woli podazal za zrenica.

To wykluczalo kompozycje obrazu w scenach dynamicznych . w statycznych jak np krajobraz dzialalo przewidywalnie , ale wowczas bylo niepotrzebne , nic nie wnosilo nowego.

@molon_labe

O istnieniu matryc BSI przed aparatami (konsumenckimi) w nie wyposażonymi miałem na studiach z astronomii, bo między innymi w tej dziedzinie były wykorzystywane. Mógłbym poszukać dokładnych danych, ale równie dobrze możesz to zrobić Ty, jeśli Ci zależy.

A co do braku praw do nazwy: Nie mam żadnych danych, żeby ktokolwiek miał jakiekolwiek prawa do tej nazwy i jakoś na szybko nie mogę ich znaleźć. Nazwa jest powszechnie używana w branży do opisu tej technologii bez względu na producenta.

Są natomiast nazwy zawierające skrót BSI zastrzeżone przez inne firmy. Na przykład "OmniBSI" firmy Omnivision:

link

Podobnie z nazwami/skrótami typu "CMOS". Typowa, powszechna w branży półprzewodników nazwa, do której nikt nie posiada praw. Też potrzebujesz na to dowodów?

Przeważnie to działa w odwrotną stronę. Jeśli twierdzisz, że ktoś posiada prawa do jakiejś nazwy, to do uwiarygodnienia tego twierdzenia potrzebny jest dokument to potwierdzający.

@Bahrd

W 1D Mk III można zrobić zdjęcie kartki..

We wszystkich wcześniejszych od R3 Canonach TRZEBA zrobić zdjęcie kartki (lub czegoś w podobie), potem znaleźć to zdjęcie wśród wykonanych, oznaczyć że ma być wzorcem bieli. A na koniec przełączyć WB w tryb wg wzorca.

W normalnych ;-) cyfrówkach procedura jest znacznie prostsza, bo nie trzeba robić zdjęcia. Szczytem luksusu były dawniej wyższe modele Olympusa (i chyba któraś Minolta), które miały dedykowany przycisk One-Touch-WB, czy jakoś tak. Celowało się środkiem kadru w szarość, przycisk, i WB było ustawione.

Za drogie to. Do zrobienia dobrych fotek wystarczy sprzet za 1/3 ceny. Reszta zalezy od fotografa, a nie aparatu

Czy wniesie coś ten aparat w jakości obrazu, myślę, że nie

"Kalibrację robiliście w okularach czy bez?" - bez okularów

@f-nieobiektywny

Ten patent z celowaniem i przyciskiem to zupełnie jak w kamerach od zawsze odkąd pamiętam. Może to pozytywny skutek upodabniania się do siebie kamer i aparatów? :)

@f-nieobiektywny

:) Oly E-10. Wygodne to było.

BTW. Prawie czterdzieści postów i spokój ws. ile klatki jest w klatce.

gdzie sie podziali lamenciarze Nikona ? ahh no tak, przeciez nie ma nawet do czego tego aparatu porownac..

@maciej.latallo

Fajnie by było jakbyście w teście wersji finalnej sprawdzili czy okulary mają jakiś wpływ.

24 Mpix, czyli rozdzielczość koloru 6 Mpix - słabo, jak na sprzęt za ponad 20 k. Za to do filmowania ( wysoki FPS przy wysokiej rozdzielczości) rewelacja.

Kyle14 września 2021, 22:38

24 Mpix, czyli rozdzielczość koloru 6 Mpix - słabo, jak na sprzęt za ponad 20 k. Za to do filmowania ( wysoki FPS przy wysokiej rozdzielczości) rewelacja.

-------------------

znowu jakies glupoty wypisujesz

rozdzieczosc koloru wynosi :

2^14^3= 4398046511104

sprawdz na bardzo kolorowych zdjeciach jpg ile licza one kolorow. jesli osiagniesz 400 000 - 500 000 to jestes juz dobry.

@Pokoradlasztuki

Znowu nie myślisz. Chodzi o rozdzielczość koloru, a nie ilość kolorów/kwantyzację koloru. Poczytaj sobie jak zbudowana jest typowa matryca światło czuła w typowym aparacie i ile jest np. pikseli czerwonych, w aparacie sprzedawanym jako 24 megapikselowy. ... jak sądzisz że pikseli/subpikseli/senseli czerwonych jest 24 miliony, to jesteś w błędzie.

przestalbys wypisywac wreszczie glupoty.

@Pokoradlasztuki

@14 września 2021, 22:58

>przestalbys wypisywac wreszczie glupoty.

Proste pytanie: ile senseli z filtrem czerwonym, ma matryca tego Canon EOS R3, skoro ma matrycę RGGB 24 Mpix ?

matryca r3 jest w stanie rozroznic 2^14^3= 4398046511104 kolorow

i to jest jej rozdzielczosc koloru.

inaczej mowiac , gdyby sfotografowac wyidealizowana tablice na ktorej znajduje sie tyle kolorow , teoretycznie matryca jest w stanie je wszystkie rozroznic .

sama matryca zapisuje obraz czarno bialy , nie jest w stanie zapisac koloru , ale dzieki interpolacji RGB udaje sie kolory zrekonstruowac.

gybys sfotografowal jednolita tablice np czerwonoa , to dostaniesz z tej matrycy obraz skladajacy sie z 24 mpx punktow obrazowych wylacznie czerwonych.

nie rozumiesz jak dziala interpolacja RGB. Ta matryca moze zapisac 24 mpx punktow w odcieniu czerwonycm a tych odcieni czerwieni moze byc 2^14=16384. Tyle odcienie szarosci zapisauje ta matryca / kanal.

to jest uklad trojwymiarowy - 24 mpx punktow powierzchniowo w kierunku x , y oraz 16384 punktow szarosci w kierunku osi z

@Pokoradlasztuki

@14 września 2021, 23:55

>Ta matryca moze zapisac 24 mpx punktow w odcieniu czerwonycm

Problem w tym, że właśnie matryca nie może zapisać takiej ilości punktów w odcieniu czerwonym.

>gybys sfotografowal jednolita tablice np czerwonoa ,

> to dostaniesz z tej matrycy obraz skladajacy sie z 24 mpx punktow

> obrazowych wylacznie czerwonych.

Nie. Gdybym sfotografował czerwoną tablicę, to matryca zarejestruje 6 mln punktów czerwonych ze stanem wysokim, 12 mln punktów zielonych ze stanem niskim i 6 mln punktów ze stanem niskim. Program interpolujący (demozaikujący) wyrzuci nam 24 czerwone megapiksele ... dokładnie tak samo będzie, jeśli sfotografujemy 6 milionów czerwonych punktów, na czarnym tle, z takim umiejscowieniem, by znajdowały się dokładnie w miejscu 6 mln czerwonych senseli. Jeśli te czerwone punkty zostaną odpowiednio przesunięte wzgl. punktów matrycy, to wyjdzie mi czarne zdjęcie.

>nie rozumiesz jak dziala interpolacja RGB

Nie rozumiesz jak działa interpolacja koloru w matrycach RGGB i dlaczego rozdzielczość koloru (np. czerwonego) matrycy 24 Mpix, nie jest równa 24 Mpix.

>to jest uklad trojwymiarowy - 24 mpx punktow

>powierzchniowo w kierunku x , y oraz 16384

> punktow szarosci w kierunku osi z

Tyś jest cały jak osia. Matryca światło-czuła rejestruje 24 milionów punktów, z czego punktów czerwonych jest 6 milionów, punktów zielonych jest 12 milionów i punktów niebieskich jest 6 milionów.

Każdy z tych punktów może mieć 16384 odcienie "jasności", ale ten temat narazie se zostaw, skoro o nim nie rozmawiamy.

Obraz końcowy 24 megapikselowy, jest efektem ostrej interpololacji informacji o kolorze z sąsiadujacych pikseli ("senseli") i właśnie tutaj jest pies pogrzebany, bo to tylko interpolacja, która potrafi generować błędy (artefakty). REALNA rozdzielczość koloru matrycy Bayera RGGB 24 Mpix nie jest równa 24 Mpix (zjawisko podobne do tego co się dzieje przy subsamplingu koloru)

@Kyle: co ty chcesz powiedzieć? że przedwczoraj dowiedziałeś się jak działają matryce? że ktoś kradnie miliony? mam nadzieję, że nigdy nie dotrze do ciebie informacja jak się tworzy jpg'i czy o zgrozo mp3, dolby surround. lepiej weź mocne leki na uspokojenie przed wiadomością jak nam serwują, oszuści ruchome obrazy, zwane filmami... o co ci chodzi, brakuje ci rozdzielczości w 2021 w topowych puszkach? kup smartfona, albo dwa, tam masz 106x3 razy 2

Ja stane po stronie Kyle.

Dzis mnie w artykule tym tu, o R3 dalej wkurza ze Optyczni pisza o 3, czy 5 czy tam 7 mln punktow "swietlnych, obrazowych, staram sie to ignorowac bo mnie zlosci" a nie moga wprost napisac jaka rozdzielczosc ma wyswietlacz czy ekran, mozna to podac w czyms strawnym, jak VGA, FullHD, WUXGA, itp czy po prostu w MP.

Tak samo z sensorami, mamy 24MP interpolowanej kaszy, Feavon pokazal co daje brak Bayera.

Nie chodzi mi o to ze brakuje, tylko o to ze sa pewne niescislosci, hehehe, a ze nikt nie oponuje to Samsung zrobil 100MP, a teraz pokaze 600MP. I jest postep.

Za rok sie pokaze moze na YT recenzje jakto smartfon jest 10x lepszy bo ma 600MP a nie 60MP jak topowy aparat.

A wiele babc i amatorow w to uwierzy i wyda 2000 usd na aparat wielkosci pudelka zapalek.

A kaszka ciagle taka sama.

@DonYoorando

@15 września 2021, 00:40

>o co ci chodzi, brakuje ci rozdzielczości w 2021 w topowych puszkach?

W tej mi brakuje, po uwzględnieniu ceny, bo do tańszego Sony A7R IV nie mam zastrzeżeń :]

>kup smartfona, albo dwa, tam masz 106x3 razy 2

Niestety nie jest tak różowo w smartfonach, ale wolę Cię nie uświadamiać jak tam sprawa wygląda, bo nawet leki Ci nie pomogą jak się dowiesz ;) ;) ;)

BlindClick

FOVEON to wspaniała przyszłość i trzymam...pieniądze, że się Sigmie uda.

Obecnie działająca komercyjnie matryca nie posiadająca filtrów barwnych jest np w Q2 Monochrom, nie wymaga interpolacji, aparat rejestruje tylko czyste natężenie światła.

Kyle15 września 2021, 00:29

>to jest uklad trojwymiarowy - 24 mpx punktow

>powierzchniowo w kierunku x , y oraz 16384

> punktow szarosci w kierunku osi z

Tyś jest cały jak osia. Matryca światło-czuła rejestruje 24 milionów punktów, z czego punktów czerwonych jest 6 milionów, punktów zielonych jest 12 milionów i punktów niebieskich jest 6 milionów.

-----------------

strasznie pieprzysz , nie znasz odstawowych pojec.

matryca nie jest w stanie zapisac jakiegokolwiek koloru , zapisuje jedynie stopnie szarosci.

rozdzielczosc koloru to cos innego.

gdybys mial matryce RGB 24 mpx , w ktorej filtr bajera zawiera 6 mpx filtrow czerwonych a byla to matryca 2 bitowa to rozdzeieczosc kolorystyczna wynosilaby :

2^2^3=64

taka matryca mimo 6 milionow filterkow czerwonych jest w stanie pokazac tylko 64 kolory. miliony rozroznialnych barw w naturze zostana sprowadzone przez matryce do 64 kolorow - to jest jej rozdzielczosc kolorystyczna.

a gdyby byla to matryca 100 mpx ( 25 mpx filtrow R) tez dwubitowa ?

To samo , rozdzielczosc kolorystyczna wynosic bedzie 64 kolory.

w matrycy RGB scanowane jest natezenie swiatla pod filtrem , czyli jedna skladowa koloru naturalnego , pozostale skladowe sa wyliczane na podstawie pomiaru w punktach sasiednich matrycy. To nie jest tak ze rejestrowane sa oddzielnie tylko punkty R, G , B w naturze , a pozostale sa niewidoczne.

rejestrowana jest skladowa kolorystyczna kazdego koloru wystpujacego w kazdym punkcie matrycy.

W matrycy co do zasady nie ma subpixeli , one wystepuja dopiero w monitorze aby pokazac oddzielnie skladowe R,G,B .

w zapisanym pliku obrazowym RGB ( czyli po demozaikowaniui ) kazdemu pixelowi zostaja przypisane 3 wartosci - R,G,B.

jesli nasza matryca R3 , 14-to bitowa sfotografujesz i zrekonstruujesz kolor dla jednolitej powierzchni np R , to mimo 6 mpx filtrow czerwonych , zostanie prawidlowo zrekonstruowany obraz dla wszytkich 24 mpx obrazu = liczbie senseli matrycy.

Rozdzielczosc kolorystyczna R3 jest na aktualnym b. wysokim poziomie - znacznie wyzszym , niz mozna to pokazac na ekranie monitora.

Interpolacja RGB ogranicza rozdzielczosc przestrzenna , niewatpliwie tak jest , ale nie jest to cos decydujacego w praktyce .

Istotą jest to, że praktycznie we wszystkich urządzeniach rejestrujących obraz mamy system Bayera. Dlatego deliberowanie przy porównywaniu czy to trzeba podzielić przez 4 czy też nie,nie ma za bardzo sensu. Dodam, że proces demozaikowania, jest na tyle skuteczny, przy porównaniu zdjęcia zrobionego aparatem cyfrowym i zeskanowanym z filmu gdzie faktycznie w każdym miejscu jest informacja rgb jakieś artefakty pojawiają się jedynie czasami. Ale też warto wiedzieć, że 6 prawdziwych megapikseli to obraz bardzo dobre jakości. Ludzkie oko zarejestruje zapewne ok coś pomiędzy 4 a 5 megapikseli, o ile mamy dobry wzrok.

@Pokoradlasztuki

@15 września 2021, 08:20

>strasznie pieprzysz , nie znasz odstawowych pojec.

>matryca nie jest w stanie zapisac jakiegokolwiek koloru

> , zapisuje jedynie stopnie szarosci.

Nad każdą foto-diodą masz przecież filtr barwny (np. czerwony), dzięki czemu wiesz, że poziom sygnału jaki odczytujesz z tej foto-diody, odpowiada z poziom koloru czerwonego.

Panowie,

chętnie poczytam wasze wpisy i wierzę, że czegoś nowego się dowiem.

Znam już powtarzane wielokrotnie : "pieprzyć głupoty", "nie masz pojęcia", "weź mocne leki"...

więc może dla odmiany coś o ...technologii obrazowania?

@Pokoradlasztuki

@15 września 2021, 08:20

>Rozdzielczosc kolorystyczna R3 jest na aktualnym b. wysokim poziomie

... niższym, niż w przypadku starego Sony A7R II :)

@Pokoradlasztuki

@15 września 2021, 08:20

>Interpolacja RGB ogranicza rozdzielczosc przestrzenna

> , niewatpliwie tak jest

>, ale nie jest to cos decydujacego w praktyce .

No niestety z powodu niższej rozdzielczości koloru, niż Ci się wydaje i procesu rejestracji do mozaiki, a następnie procesu demozaikowania, w praktyce, jeśli sfotografujemy odpowiednio mały czerwony napis, na białym tle, to wyjdzie on na zdjęciu szary.

@Pokoradlasztuki

@15 września 2021, 08:20

>rozdzielczosc koloru to cos innego

Nazywanie ilości odcieni "rozdzielczością koloru" jest nieprawidłowe (nawet jak użyto takiego określenia w książkach, które czytałeś). Prawidłowe nazewnictwo to ew. "ilość odcieni", "gradacja" lub powiedzmy "rozdzielczość gradacji", tudzież inna "głębokość bitowa", alternatywnie "ilość bitów na kanał".

Molon: "więc może dla odmiany coś o ...technologii obrazowania?"

Przednia myśl! Obawiam się jednak, że jeśli nie sprowadzimy dyskusji do poziomu fotonów, to nie dojdziemy do porozumienia... A i potem też łatwo nie będzie: [ link ].

@Pokoradlasztuki

@15 września 2021, 08:20

>w matrycy RGB scanowane jest natezenie swiatla pod filtrem

W matrycy RGGB jak już coś. Pod filtrem czerwonym, masz wycięte widmo niebieskie i zielone - nie bardzo dopuszczasz to do świadomości.

> pozostale skladowe sa wyliczane na podstawie pomiaru w punktach

> sasiednich matrycy

Tak, pozostałe składowe dla obszaru pod filtrem czerwonym, są istotnie INTERPOLOWANE z oddalonych obszarów (G i B), ale odbywa się to PO zarejestrowaniu obrazu przez matrycę, czyli dopiero przy procesie demozaikowania. ... i cały ten proces, zaczynający się już na etapie rejestracji przez matrycę, a kończący się na demozaikowaniu, generuje w pewnym stopniu zniekształcenia obrazu.

>. To nie jest tak ze rejestrowane sa oddzielnie tylko punkty R, G , B

Dokładnie tak jest. Pod filtrem czerwonym, jest rejestrowany tylko i wyłącznie odcień czerwony. To że w jego miejscu dostajesz na gotowym np. PNG kolor z informacją nie tylko R, ale też G i B, wynika z procesu demozaikowania, czyli interpolacji brakujących G i B z sąsiadujących obszarów. Jak chcesz się przekonać, co matryca rejestruje, to wyłącz sobie demozaikowanie na otwartym RAW (w np. RawTherapee można to zrobić).

Bahrd

:)

Kyle

osobiście najbardziej lubię "głębokość bitowa" , ale rozumiem co jest pod "rozdzielczością koloru"

Do obrazu podstaw fotografii cyfrowej należy jeszcze dodać rodzaj przestrzeni barwnej ustawionej w aparacie. To temat do rozwinięcia przez @pokorę - ja się nie czuję na siłach.

Przypominam tylko, że nie każdy kto pieprzy głupoty jest głupi, półanalfabetyczny, czy na głodzie. Domyślam się jednak, że są to środki wzmacniające siłę wyrazu ;-)

@cedrys

@15 września 2021, 09:10

>Do obrazu podstaw fotografii cyfrowej

>należy jeszcze dodać rodzaj przestrzeni barwnej

Proponuję chwilowo nie poruszać kwestii "zakresu barwnego", zwanego przez niektórych "przestrzenią kolorystyczną/kolorów", lub bardziej potocznie "gamut'em", bo nam się całkiem @Pokoradlasztuki zagotuje :)

@Kyle

"Dokładnie tak jest. Pod filtrem czerwonym, jest rejestrowany tylko i wyłącznie odcień czerwony."

Jaki odcień czerwony, podasz w nm? A ten filtr to jaki jest: pasmowy, dolno- czy górnoprzepustowy?

Kyle15 września 2021, 08:52

@Pokoradlasztuki

@15 września 2021, 08:20

>Interpolacja RGB ogranicza rozdzielczosc przestrzenna

> , niewatpliwie tak jest

>, ale nie jest to cos decydujacego w praktyce .

No niestety z powodu niższej rozdzielczości koloru,

------------------

to nie ma nic wspolnego z rozdzielczosci koloru to jest kwestia rozdzielczosci przestrzennej.

wskutek interpolacji RGB czerwony punkt zostanie rozjasniny skladowymi z punktow sosiednich , czyli przejdzie w roz , zas sasiednie biale zostana " zarazone" skladowymi z punktu czerwonego, pojawi sie na nich wplyw skladowej czerwnieni . Obraz czerwonego punktu zostanie lekko rozmyty , to jest ten spadek rozdzielczosci przestrzennej. Ale to tylko teoretyczna dywagacja , dlatego ze matryca nie jest w stanie rozrozniac elementy o wielkosci 1 pixela. Powierzchniowo potrzebne sa 4 sensele , a to sie miesci w interpolacji RGB. Taki opisany przypadek w praktyce nie zajdzie .

Po prostu aby rozroznic elementy w ogole miedzy soba musza byc wieksze od jednego sensela - liniowo 2 razy , powierzchniowo - 4.

Nie ma ta interpolacja istotnego wplywu na rozdzielczosc kolorystyczna, ona jest b. dokladna , choc oczywiscie bledy moga ale nie musza wystapic.

Interpolacja jest b. subtelna.

@cedrys

@15 września 2021, 09:20

>Jaki odcień czerwony, podasz w nm?

Czerwony to obszar w widmie światła gdzieś w rejonach długości fali 700 nanometrów. Tutaj:

link

określono go na zakres 625 - 740nm, choć tak na prawdę jak dobrze pamiętam nawet 780 nm jest jeszcze w zakresie widzialnym.

@Pokoradlasztuki

@15 września 2021, 09:20

>to nie ma nic wspolnego z rozdzielczosci koloru

>to jest kwestia rozdzielczosci przestrzennej.

Jest to rozdzielczość koloru ... w przestrzeni. Tak jak zwykle mówimy o rozdzielczości ekranu - również mamy na myśli rozdzielczość przestrzenną.

@Kyle

Ale zapomniałeś jak się pisze "naprawdę"...

@Pokoradlasztuki

@15 września 2021, 09:20

> Obraz czerwonego punktu zostanie lekko rozmyty

> , to jest ten spadek rozdzielczosci przestrzennej.

> Ale to tylko teoretyczna dywagacja

To jest właśnie problem z Tobą. Za dużo teoretyzujesz, a za mało wiążesz teorię z praktyką. Sfotografuj sobie czerwony napis, prostą czcionką, na białym tle z dostatecznie dużej odległości, tak by grubość linii litery była na poziomie zbliżonym do jednego piksela na zdjęciu. Zobaczysz PRAKTYCZNIE co się dzieje i jak ograniczona rozdzielczość koloru ("w przestrzeni") potrafi przekłamać obraz. Na obrazach testowych z optyczne.pl też można wyłapać miejsca, gdzie niska rozdzielczość koloru("w przestrzeni"), a właściwie niższa od całkowitej ilości pikseli, powoduje artefakty koloru.

@cedrys

@15 września 2021, 09:29

>Ale zapomniałeś jak się pisze "naprawdę"...

No żeś mnie tera zażył kileeeer, yyy cedryyysssss . No naprawdę :]

nie

masz rozdzielczosc przestrzenna - ktora podaje sie np w lp/mm

i rozdzielczosc tonalna ktora podaje sie w np l. bitow.

rozdzielczsc kolorystyczna wynika z rozdzielczosci tonalnych na wszystkich 3 kanalach. To jest liczba mozliwsych kombinacji tonalnych na 3 kanalach czyli liczba mozliwych kolorow.

przy poteznej rozdzielczosci przestrzennej mozesz miec teoretycznie niska rozdzielczosc kolorystyczna.

rozdzielczosci kolorystyczna mowiac inaczej to zdolnosc do rozrozniania koloru.

przestrzen barwna jest przestrzenia euklidesowska 3D. pomiedzy kolorami mozna wyliczyc ich wzajemna odleglosci tak jak sie liczy odleglosci w przestrzeni euklidesoweksiej . Im mniejsza mozliwa najmniejsza odleglosc miedza kolorami tym wyzsza rozdzielczosc kolorystyczna. Wiekszej liczbie mozliwych kolorow w danym zakresie tonalnym odpowiada wieksza gestosc , czyli zdolnosc do rozrozniania mniejszych roznic miedzy kolorami.

w matrycy 2 b mamy 64 kolory RGB

w matrycy 12 b mamy 4096^3 kolorow

to jest rozdzielczosc kolorystyczna.

monitory 8b maja 16,8 mil barw - taka jest ich rozdzielczosc kolorystyczna.

rozdzilczsoc przestrzenna moze wynosic np 72 dpi.

"W pełni naładowany akumulator ma pozwolić wykonać 860 zdjęć z użyciem ekranu lub 620 przy wykorzystaniu wizjera."

Nie powinno być odwrotnie? Więcej zdjęć przez wizjer, a nie przez ekran.

Dyskusja zaczęła się od stwierdzenia, że 24 megapiksele to mało. Czy to w rzeczywistości 6 megapikseli rzecz do dyskusji. Sedno sprawy jest takie, że powtórzę: prócz matrycy Sigmy, wczesny matryc typu plastra miodu wszystkie matryce dziś są typu Bayera. Oczywiście to prawda, że występują różne efekty procesu demozaikowania, ale we wszystkich urządzeniach jest tak samo. Więc można porównać rozdzielczość nie zajmując się demozaikowaniem. Wszędzie, w tym takze w telefonach mamy te same problemy. Pytanie, czy rozdzielczość aparatu mimo tych 24 megapikseli jest większa, czy mniejsza od rozdzielczości telefonów? Oczywiście jest dramatycznie większa, bo w aparacie można założyć optykę, która te 24 megapiksele faktycznie da. W telefonach mamy w porywach ok 6 megapikseli.

baron1315 września 2021, 10:40

Dyskusja zaczęła się od stwierdzenia, że 24 megapiksele to mało.

----------------

nie przeczytales uwaznie -

zaczela sie od stwierdzenia, ze rozdzielczosc koloru R to 6 mpx czyli malo

cytat :

"24 Mpix, czyli rozdzielczość koloru 6 Mpix - słabo, jak na sprzęt za ponad 20 k"

rozdzielczosc koloru jest znacznie , znacznie wyzsza.

@Pokoradlasztuki

@15 września 2021, 09:41

>masz rozdzielczosc przestrzenna - ktora podaje sie np w lp/mm

W pikselach też się podaje i jest to nawet znacznie popularniejsze.

@baron13

@15 września 2021, 10:40

>W telefonach mamy w porywach ok 6 megapikseli.

To też nie jest prawda, co można sprawdzić przy pomocy dobrego telefonu (z dużą matrycą o wysokiej rozdzielczości).

@Pokoradlasztuki

@15 września 2021, 10:48

>rozdzielczosc koloru jest znacznie , znacznie wyzsza.

W takim razie czemu powstają artefakty o których pisałem wcześniej na 24 megapikselowaych zdjeciach? (z aparatów sprzedawanych jako 24 Mpix)

>monitory 8b maja 16,8 mil barw - taka jest ich rozdzielczosc kolorystyczna.

Nazywanie tego jak to robisz jest błędem i wprowadzaniem chaosu.

>rozdzilczsoc przestrzenna moze wynosic np 72 dpi

Jak nazwiesz informację typu 3840x2160 podawaną przy monitorach? :)

>rozdzielczosci kolorystyczna mowiac inaczej to zdolnosc do rozrozniania koloru

Mieszasz pojęcia. Zrozum że rozdzielczość koloru może być niższa niż rozdzielczość obrazu, które to zjawisko zachodzi też np. w przypadku subsamplingu koloru (rozdzielczość koloru jest niższa niż rozdzielczość "jasności")

@Pokoradlasztuki

Czy w ogóle rozumiesz, że przez cały czas piszę o spadku rozdzielczości obrazu pod wzgl. chrominacji? :) Innymi słowy, rozdzielczość obrazu pod wzgl. senseli czerwonych w matrycy RGGB 24 Mpix NIE wynosi 24 mln punktów. Tam nie ma 24 mln senseli czerwonych!!!

@Pokoradlasztuki: z dalszej awantury jasno wynika, co autor wypowiedzi chciał powiedzieć, a co nie za bardzo się udało :-)

@Kyle: po pierwsze trzeba dostać telefon z dostępnymi prawdziwymi nieobrabianymi rawami. Zawsze bowiem jest ten problem :

link

Spojrzeć na dół strony ostatni wykres. Sprawa druga, że z rozmiarów optyki nie wynikają żadne rewelacyjne możliwości. Zwykle mówi się o limicie dyfrakcyjnym, ale weź pod uwagę że dokładność obróbki jest bardzo zblizona dla wielkich i maluśkich soczewek. Ten efekt rozmiarowy jest bardzo wyraźnie widoczny w optyce aparatów. Duże LF z optyką z lat 60-tych są lepsze od współczesnych fufu licząc w linach na wysokość czy szerokość obrazu. Takie błędy jak nawet nieosiowość liczona nie w stopniach ale w mikrometrach się skaluje. Dlatego np w LF czołówka z obiektywem jest ruchoma, bo da się ją ręcznie właściwie ustawić. W aparatach z ogniskową kilku-kilkunastu milimatrów jest to nie możliwe.

Kyle15 września 2021, 11:13

@Pokoradlasztuki

Czy w ogóle rozumiesz, że przez cały czas piszę o spadku rozdzielczości obrazu pod wzgl. chrominacji? :)

-----------------

ja sie ustosunkowalem do Twojej wypowiedzi, ze rozdzielczosc koloru 6 mpx dla R w aparacie R3 jest malo. ( slowo chrominacja nie padlo , jeszcze wowczas nie zdawales sobie sprawy z tego co piszesz)

To sa wyssane z palca domorosle wymysly , nawet nie teorie.

najwyrazniej nie rozumiales piszac swoj post czym jest rozdzielczosc kolorystyczna.

byc moze teraz juz wiesz.

na inny temat dyskusji nie podejmowalem .

o jakim spadku rozdzielczosci pod wzgledem chrominnacji w ogole mowisz ? spadku w stosunku do czego ? To jest matryca o aktulanie b wysokiej rozdzielczosci pod wzgledem chrominacji . na palcach jednej reki w drogich aparatch MF mozna szukac przetwornikow wiecej niz 14 b.

W zakresie aparatow FF - aparat daje najwyzsza aktualnie stosowana i osiagalna rozdzielczosc " w zakresie chrominancji "

Aparat R3 ma rozdzielczosc kolorystyczna na aktualnym wysokim poziomie , wynikajaca z 14 b przetwornika. Co do zakresu tonalnego - trzeba poczekac na pomiary , oczekuje ze bedzie rowniez na aktualnym poziomie , a moze nawet nieco lepszym czego moznaby oczekiwac od najnowszej matrycy BSI .

@Pokoradlasztuki

Nadal udawaj głupiego.

@baron13

@15 września 2021, 11:17

>@Pokoradlasztuki: z dalszej awantury jasno wynika, co autor wypowiedzi >chciał powiedzieć, a co nie za bardzo się udało :-)

Autor (JA) powiedział jak należy, ale pokoradlasztuki wyłączyła myślenie i zaczęła snuć zwoje wywody na temat gradacji i ilości bitów koloru na piksel, czyli na inny temat.

>@Kyle: po pierwsze trzeba dostać telefon z dostępnymi prawdziwymi >nieobrabianymi rawami

Każdy dobry telefon ma taką opcję.

>W zakresie aparatow FF -

> aparat daje najwyzsza aktualnie stosowana i osiagalna rozdzielczosc

>" w zakresie chrominancji "

W zakresie rozdzielczości koloru jest kiepsko jak na aparat za ponad 20K - tylko 6 mln senseli czerwonych.

@Kyle: co dostępności nieobrobionych rawów to jest poważny znak zapytania. Pogrzeb sobie w testach Optycznych a zobaczysz, że ewidentne "oszukiwanie" rawów jest na porządku dziennym w wielu aparatach. Po mojemu, bo to niestety sprawa dość tajemnicza, objęta firmowymi zastrzeżeniami, wynika ten efekt bardziej z technologii obróbki sygnału niż z chęci "oszukania" użytkownika. W efekcie dostajesz zapis w formacie zbliżonym do raw. To znaczy masz zapis zdjęcia z większą ilością informacji niż w przysłowiowym jotpegu, ale diabli wiedzą co on naprawdę oznacza. Da się wyznaczyć, tylko z gorszą dokładnością faktyczne rozdzielczości matryc przyjmując za miernik nie spadek kontrastu ale zanik linii na tablicy. To własnie widać w rozmiarach publikowanych zdjęć z telefonów i w porywach odpowiada on 5-6 megapikselom. Co też jest bardzo dobrym wynikiem. Ale nie tak dobrym jak w przypadku aparatów fotograficznych, gdzie jak się postarasz to możesz wyciąć 1;1.

@baron13

Sample publikowane z telefonów, to zwykle faktycznie straszny śmietnik, bo zwykle to są jpg z fabrycznej aplikacji, która nakłada wiele filtrów (wyostrzanie krawędzi i rozmywanie szumów to taki standard). Inna sprawa, że lustrzanki z tego co widzę też zwykle nakładają takie filtry (przy zapisie do jpg), ale mniej agresywnie (mniejsza siła wyostrzania i mniejsza siła rozmywania szumów).

Nie mniej jednak można uzyskać jpg pozbawione wyostrzania, nawet bez sięgania po RAW. Wystarczy program OpenCamera (to program do obsługi aparatu, zamiast fabrycznej aplikacji), w którym po wybraniu trybu pracy w Api2 pojawiają się opcje wyłączenia wyostrzania całkowicie, jak i możliwość całkowitego wyłączenia odszumiania. Przy pomocy takich plików już można coś ocenić ew. zmierzyć.

Swoją drogą optyczne.pl zrobiło fajny pomiar, choć niestety jest to telefon, z malutką matrycą 1/2,55":

link

@Amadi

"Ten patent z celowaniem i przyciskiem to zupełnie jak w kamerach od zawsze odkąd pamiętam."

Ale tylko Oly i nieboszczka Minolta przeniosły do siebie ten patent w formie nieskażonej. Czasem w innych sprzętach dało się podpinać tę funkcję pod definiowalny klawisz. Może teraz i w R3 się da? Trzeba by pogrzebać w menu...

Kojarzy mi się też nietrafiona interpretacja określenia One-Touch-WB przez któregoś producenta - Samsunga? Kodaka? Na przycisku u Olympusa widniał standardowy symbol balansu WB wg wzorca. Stąd komuś strzeliło do głowy, by łantaczem nazywać ten sposób działania WB. I w instrukcjach mieliśmy balans automatyczny, żarowy, dzienny, świetlówkowy i One-Touch. Pomimo, że za ChRL nie dało się go ustawić go za pomocą jednego przyciśnięcia.

@baron13

"po pierwsze trzeba dostać telefon z dostępnymi prawdziwymi nieobrabianymi rawami"

@Kyle

"Każdy dobry telefon ma taką opcję. "

No niestety. Mój Samsung S20 Ultra ma matrycę 108 MPx i da się zapisać jpega w tej rozdzielczości, ale już rawa dostaniemy tylko 12 MPx :(

@wzrokowiec

Tak, właśnie już o tym wspominałem (może w innym temacie), że rozdzielczość RAW, jaką masz do dyspozycji w telefonach, jak i rozdzielczość jaką możesz robić naturalne zdjęcia dzięki OpenCamera, jest rozdzielczością filtra Bayera.

Niestety w Samsung S20 Ultra wynosi ona jedynie 12 Mpix - tak bardzo schlastali rozdzielczość filtrów koloru w tej matrycy. Szkoda, że nie użyli modelu ISOCELL HMX, który ma tą rozdzielczość znacznie wyższą (ponad 27 Mpix).

@wzrokowiec

"No niestety. Mój Samsung S20 Ultra ma matrycę 108 MPx i da się zapisać jpega w tej rozdzielczości, ale już rawa dostaniemy tylko 12 MPx :("

Bo on ma matrycę 12 mpix. 108 fotodiod ale tylko 12 mpix.

Jeden piksel jest tworzony przez 9 fotodiod, ale marketing to sprzedaje jako 108 zamiast 12.

Podobnie (ale na mniejsza skalę) w Canon w matrycach DPAF występują po dwie fotodiody na piksel. Ale na szczęście Canon nie wpadł na idiotyczny pomysł by to reklamować jako matryce o dwukrotnie większej rozdzielczości

To już przeszłość - od dziś pod każdym pikselem HP1 Samsung ma szesnaście fotodiod! I nawet wyciska z tego 8K... :)

Fajny ten gibany ekran, taki amatorski, jak w 60D ;)

Pucha spoko, dla promila fotografujących w PL. Za rok lub półtora R1x i tak w kółko...

Może, któryś z redaktorów optyczne wskaże kto ma rację w tej wojence w komentarzach powyżej ???

W końcu aparat co ma wszystko :)

Jak tylko będzie w sklepie to bierę :D

smutne, że ktoś może tylko widzieć, "słabą rozdzielczość koloru" w R3. przypomina mi się anegdota o sondzie ulicznej dla telewizji na temat skojarzeń białego koloru. jedni mówią że śnieg i zima, inni , że rasizm, jeszcze inni mleko. a @Kyle mówi że z dupą mu się biały kojarzy. z dupą, dlaczego? bo mu się wszystko z dupą kojarzy...

może wszyscy reporterzy świata od lat są ślepi i nie widzą rozdzielczości kolorów? pewnie gdzieś w okolicach 1D3 i D3 wszczepili im chipy do kontroli mózgu.

DonYoorando16 września 2021, 02:33

smutne, że ktoś może tylko widzieć, "słabą rozdzielczość koloru" w R3.

---------------

nie nalezy traktowac powaznie wypowiedzi niepowaznych.

to nie jest powod do smutku , ale raczej do rozrywki.

tak wiec nie smuc sie , a raczej ciesz , ze istniaja zabawne wypowiedzi.

R3 ma rozdzielczosc kolorystyczna na najwyzszym aktualnym poziomie.

Jesli ktos zastepuje szare komorki komorka samsunga to moze byc tylko zabawnie.

Pokoradlasztuki

Filtr Bayera "nie jedno ma imię" i błędem jest założenie, że jest zbudowany klasycznie, jako mozaika :

G R G R

B G B G

G R G R

B G B G

wcale tak być nie musi, można zastosować inne np:wersję filtra z cyjanem, magenta i żółtym, który ma wyższą "wydajność kwantową" (to inne zagadnienie).

Aby przejść z obrazu „wzór Bayera” do obrazu pełnokolorowego, oprogramowanie aparatu korzysta z algorytmów i tu jest siła firm.

Algorytmy Canona mogą mieć bardziej "szczegółowe" przybliżenia, a wydajniejsze procesory szybciej je przeliczą dając dokładniejszy kolor.

Algorytmy "demozajkowania" podlegają patentom i są silniej chronione niż rozwiązania techniczne.

np: link

Dlatego nie przykładałbym tak wysokiej wagi do sensora, ale do oprogramowania własnie.

W końcu to fotografia cyfrowa.

molon_labe16 września 2021, 08:43

Pokoradlasztuki

Filtr Bayera "nie jedno ma imię" i błędem jest założenie, że jest zbudowany klasycznie, jako mozaika :

--------------

zgadza sie , taki jest fakt .

"Dlatego nie przykładałbym tak wysokiej wagi do sensora, ale do oprogramowania własnie.

W końcu to fotografia cyfrowa."

-----------

- jedno i drugie jest wazne.

wlasciwie dla nas fotografow to co widzimy to jest wynik i matrycy i obliczen + optyka . Matryce dla nas sa oferowane wraz z obliczeniami , bez tego nie byloby raw-u i dalej obrazu RGB. To jest rodzaj " czarej skrzynki " - nie mamy przeciez mozliwosci samodzielnie oprogramowac danych z matrycy.

Mowiac o matrycy tak na prawde mowimy o niej wraz z przynaleznym jej oprogramowaniem.

Jesli sa jakies cudowne algorytmy poprawiajace obraz z matryc slabych , to zapewne mozna nimi poprawic oobraz z matryc lepszych.

Czego matryca nie przeniesie tego nie ma , nie da sie odtworzyc oprogramowaniem. Mnajeszego zakresu matrcy nie rozszerzyw w komputerze - co zostalo przepalone tego nie ma w danych obrazowych.

-wszystko jest wazne.

Pokoradlasztuki

Amen

:)

@baron13:

"Ale nie tak dobrym jak w przypadku aparatów fotograficznych, gdzie jak się postarasz to możesz wyciąć 1;1."

Co rozumiesz przez wycięcie 1;1?

@Negatyw: a nie chcesz po prostu wywołać awantury ? :-) Że nie wiesz co się tu rozumie pod tym skrótem, wątpię, ale proszę bardzo. Jeśli potrzebuję pliku zdjęcia o wymiarach 11024x683 piksele to pliku zdjęcia wygenrowanego bez skalowania wycinam stosowny fragment i przekazuję dalej lub sam go używam wedle potrzeby. Na wszelki wypadek: żadne dpi, wyświetlanie takie czy owakie. Na przykład wrzucam do pliku strony internetowej z ustawionymi wymiarami zdjęcia takimi jakie ma ono informatycznie ;-) Ależ tak, wiem, różne komputery, monitory nadadzą mu różne fizyczne rozmiary. Nie szkodzi. :-)

Sorry w przykładzie (oczywiście?) chodzi o 1024x683 piksele. Jedynka więcej się sama zrobiła. No dobra , to ja...

@baron13

Wydaje mi się, że @Negatywowi chodziło jednak o średnik w "1;1".

LR15 września 2021, 17:33

Może, któryś z redaktorów optyczne wskaże kto ma rację w tej wojence w komentarzach powyżej ???

----------

nizaleznie od tego co napisalaby redakcja rzeczywistosc jest jedna. rownie dobrze moznaby przeprowadzic glosowanie kto ma racje - jesli juz do tego tak podchodzic - co byloby zaprzeczeniem zdrowego rozsadku .

Prawdy nie mozna przeglosowac.

kylie myli rozdzilczosc powierzchniowa z rozdzielczhoscia tonalna , a rozdzielczosc tonalna dla 3 kanalow to jest rozdzielczosc koloru.

prosze bardzo, przyklad:

ten aparat ma wielkosc sensela ok 6 mikrom .

powiedzmy ze fotografujemy w skali 30 :1

obszar jaki pokryje pole pojedynczego pixela na motywie wynosi : 0,006mm *30 =0,18 mm

powiedzmy ze mamy dobry obiektyw dla ktorego rozdzielczosc obrazowania wynosic bedzie 45 lp/mm.

obszar jaki mozna zidentyfikowac jako najmniejszy wynosi wiec w tej skali 30 *1/45=0,666mm , a wiec jest 4 razy wiekszy od obszaru pokrywanego przez pojedynczy pixel . oznacza to ze interpolacja rgb z 2 sasiednich pixeli nie jest ograniczeniem rozdzielczosci . W praktyce jakis tam wplyw jest ale nie jest on istotny. to nie ma wiekszego wplywu na oddanie koloru - jakies tam kolory nie beda opuszczone gdyz czestosc skanowania przez pojednycze pixele jest 4 razy wieksza od czestosci skanowania motywu przez optyke + matryce.

rozdzielczosc kolorystyczna wynika z glebi bitowej przetwornika , nie z gestosci matrycy.

dla matrycy 6 mpx jak w przeszloci rozdzielczosc tonalna mogla wynosic 4096 / kanal i dla matrycy 12 mpx tyle samo - o tym decydowal przetwornik A/D

@orbital15 września 2021, 10:33

""W pełni naładowany akumulator ma pozwolić wykonać 860 zdjęć z użyciem ekranu lub 620 przy wykorzystaniu wizjera."

Nie powinno być odwrotnie? Więcej zdjęć przez wizjer, a nie przez ekran."

Nie, nie. Wszytsko się zgadza. Więcej zdjęć zrobisz przez LCD niż przez wizjer.

@wzrokowiec: Jak tak, to dzięki, powinienem siedzieć przed monitorem w okularach. Przegapiłem.

Wizjer ma więcej punktów światłości, a to są pazerniaki na baterie.

Mnie gryzie że nie mam gdzie zobaczyć 40MP, tak 1 do 1 jak należy, bo po to noszę kg sprzętu i obrabiam olbrzymie pliki by móc na to patrzeć, inaczej komórka będzie zwycięzca.

Fajna była by ramka wielkości 60 80 cali, z dobrymi kolorami i 3fps a nawet 1fps jakbym musiał coś poświęcić.

Nie widzę innej możliwości cieszenia się z ilości mp. Drukowanie - to co innego jak już się napatrze, wybiorę i zdecyduje się mogę wydrukować zdjęcie 2m2 i powiesić, ale to efekt końcowy, dość kosztowny i czasochłonny. A robienie 50mp by potem oglądać to na 2mp i być bluzganym za to że chce się zobaczyć jak naprawdę wygląda 50mp to moim zdaniem zła droga.

Pokoradlasztuki

jakby było jednak głosowanie, to będę głosował za Twoja prawdą, ponieważ

moim zdaniem, ten fakt:

"rozdzielczosc kolorystyczna wynika z glebi bitowej przetwornika , nie z gestosci matrycy"

jest obecnie wykorzystywany przez producentów aparatów, co łatwo sprawdzić porównując zmiany w apartach serii R w stosunku do 5D Mark IV.

Oba aparty dzielą tę sama matrycę, ale inne procesory i ..Eureka!

W teście Canona R napisano:

"Dla najniższej natywnej czułości na jedną jednostkę kwantyzacji przetwornika ADC przypada nieco ponad 11 elektronów. Przy 14-bitowym przetworniku daje to pojemność studni potencjałów (ang. full well capacity) na poziomie 188 ke–. ..."

W teście Canona 5Dmark IV:

"Dla najniższej natywnej czułości na jedną jednostkę kwantyzacji przetwornika ADC przypada prawie 5 elektronów. Przy 14-bitowym przetworniku daje to pojemność studni potencjałów (ang. full well capacity) na poziomie 80 ke–..."

Ciągle mam EOSa 30 z eye control. Wybór punktu AF działa dobrze. Dlaczego Canon z tego zrezygnował?

@wzrokowiec:

"Wydaje mi się, że @Negatywowi chodziło jednak o średnik w "1;1"."

Nie. Chodzi o wypowiedź barona, wypowiedź zupełnie bez sensu, co potwierdza jego późniejsze wyjaśnienie. Jeżeli mam plik z telefonu lub z aparatu 4096x2732 pikseli i chcę go wyświetlić na monitorze o rozdzielczości: 3840x2160 1:1 to dlaczego w przypadku pliku z aparatu muszę się postarać a w przypadku pliku z telefonu się nie da?

@Pokoradlasztuki

@16 września 2021, 14:35

>kylie myli rozdzilczosc powierzchniowa z rozdzielczhoscia tonalna

> , a rozdzielczosc tonalna dla 3 kanalow to jest rozdzielczosc koloru.

Kyle nic nie myli. Od początku chodzi mi o rozdzielczość koloru na powierzchni, a nie gradację/ilość odcieni. Trzeba by analfabetą by tego nie dostrzegać. Pytanie pomocnicze: co się dzieje z rozdzielczością czerwonego napisu "Pokora dla sztuki jest analfabetą" jeśli poddamy go procesowi subsamplingu 4:2:0 (co ma miejsce często przy zapisie do JPG).

Jak ktoś nie rozumie o czym piszę, to niech sobie zrobi w paint napis Kyle czarną czcionką, następnie napis Pokoradlasztuki czerwoną i zapisze do JPG z subsamplingiem 4:2:0. ... aha ... i niech czcionka będzie mała wzgl wielkości pikseli (np. kilka pikseli wysokości max)

@Negatyw: jeśli chcesz się pochwalić, że masz monitor o dużej rozdzielczości, to napisz to, nie wstydź się :-)

@Kyle

twoje absolutnie nicniewnoszące do premiery R3 komentarze, chciałbym sfotografować napisane żadną czcionką. piszesz jakieś bzdury. ma to się nijak do rzeczywistości fotografii reporterskiej.

może zacznij spędzać więcej czasu na tematach o aparatach w smartfonach. tam ci to wychodzi rewelacyjnie. popróbuj połączyć rozdzielczość koloru z siłą sygnału 5G i producenta szczepionki.

zostaniesz dla wielu prorokiem. napiszesz książkę z wieloma ilustracjami czerwonych i czarnych czcionek, i samplingiem rawóf i jotpeguf. sprzedasz ją w setkach tysięcy swoim wielbicielom. później napiszesz kolejną, w której wszystkiemu naukowo zaprzeczysz i sprzedasz ją w setkach tysięcy reszcie. zacznij robić sample.

Takie

link

Zrobione dość beznadziejnym obiektywem:

link

Sprawa zasadnicza: nie ma sprawy rozdzielczości matrycy. Dlatego bicie piany o przestrzennej rozdzielczości najwyżej świadczy o tym, że bijący nie rozumie się na fotografii. Bardzo mi przykro, ale problem rozdzielczości matryc dawno zniknął.

@DonYoorando

@baron13

Bardzo mi przykro, ale nie "rozumiecie się na fotografii" x-P Nie rozumiecie, że niższa rozdzielczość senseli danego koloru (np. 6 mln), od ilości pikseli gotowego zdjęcia (np. 24 mln), generuje pewne zniekształcenia, przykładowo:

Jednolicie czerwony w rzeczywistości napis APTEKA, na witrynie sklepu, który na skutek tego o czym pisałem, nie jest czerwony:

link

Takie zniekształcenia można kompensować przez wyższą rozdzielczość matrycy. Tymczasem Canon EOS R3 za ponad 20 kPLN, będzie miał takie zniekształcenia WIĘKSZE, od SONY A7R II za ułamek tej kwoty.

@baron13

@16 września 2021, 21:21

>Takie

>link

>Zrobione dość beznadziejnym obiektywem:

>link

>Sprawa zasadnicza: nie ma sprawy rozdzielczości matrycy.

Wstawiłeś miniaturki zdjęcia, o wielkości 1536×1024 pikseli, z aparatu który robi zdjęcia w znacznie wyższej rozdzielczości i dziwisz się, że nie widzisz problemu? Ty na prawdę nie rozumiesz o czym pisałem. Taka miniaturka ma niższą rozdzielczość niż ilość senseli jednej składowej koloru na Twojej matrycy, więc problemu nie będzie. Ponadto wstawiasz zdjęcie jakiegoś kłębka sierści, który nie ma kolorowych, kontrastowych krawędzi (np. mały czerwony napis na białym tle), gdzie problemy o których piszę potrafią się wyraźnie pojawić.

ps. to co wstawiłem:

link

to jest nieskalowany wycinek zdjęcia, a nie jakieś zeskalowane w dół miniaturki, które wstawia baron13 i się dziwi, że nic nie widzi z artefaktów o których piszę. No nic dziwnego że nie widzi, skoro jego zdjęcia są tak przeskalowane, że mają niższą rozdzielczość od ekranu dobrego telefonu komórkowego, więc takie zniekształcenia, o których pisałem, w jego przypadku i tak zginęłyby w pikselozie jego miniaturek.

@Kyle: Nigdzie nie napisałem, że demozaikowanie nie generuje artefaktów. Wręcz przeciwnie. Dobrze by było, byś sformułował tezę. Obawiam się, że jak ją poskładasz to okaże się powiedzmy to tak, niezbyt akceptowalna. Zapewne chcesz udowodnić, że jedna te megapiksele w aparatach komórczanych. Otóż raz jeszcze: nie ma problemu rozdzielczości matrycy. Można zademonstrować sytuacje w których się objawi, to akurat nie tą drogę, którą pokazujesz, ale można. Tyle, że z tych demonstracji wyniknie, że problemu nie ma. O co chodzi w fotografii? Na przykład o cos takiego:

link

Przyjm jeszcze do wiadomości, że zwłaszcza z takiej foci można wydrukować duży plakat, że się nie połapiesz po rozmnożeniu pikseli, że piksele rozmnożone. ale też nikt nie będzie na to patrzył, tylko się uchacha z miny kota. albo znudzony minie zdjęcie, bo już cos podobnego widział, albo nie lubi kotów. To są problemy w fotografii. A rozdzielczość matrycy, to ewentualnie przedmiot bicia piany dla influencera czy innego manipulatora usiłującego naciągnąć ludność na coś niepotrzebnego.

Często rozmowa na tym forum przypomina mi dowcip:

-Co pani dolega?

-Boli mnie szyja.

-To dlaczego ma pani bandaż na nodze?

-Bo mi się zsunął...

@baron13

link

>Przyjm jeszcze do wiadomości, że zwłaszcza z takiej foci można

> wydrukować duży plakat, że się nie połapiesz po rozmnożeniu pikseli

Sugerujesz, że nie zobaczę różnicy na wysokiej jakości dużej odbitce, oglądanej z kilkudziesięciu cm, między tym zdjęciem w wersji 683x1024px, a wersją NIEprzeskalowaną tak bardzo w dół (np. 4000x6000 px)? (oczywiście zakładając, że oryginał nie jest rozmydlony, tylko jest naprawdę wysokiej jakości)

Obawiam się, że bym Ciebie zaskoczył. :)

Kyle

przeczytaj artykuł,

link

potem możemy wrócić do tej dyskusji.

W skrócie, twierdzenie:

"Takie zniekształcenia można kompensować przez wyższą rozdzielczość matrycy. Tymczasem Canon EOS R3 za ponad 20 kPLN, będzie miał takie zniekształcenia WIĘKSZE, od SONY A7R II za ułamek tej kwoty."

.......jest moim zdaniem...spekulacją manipulacyjną.

Kwestia wpływu wysokiej rozdzielczości sensora na percepcyjnie ostre obrazowanie to wielowątkowy obszar, a algorytmy przetwarzania mozaiki Bayera do pełnokolorowego obrazu zajmują sporą tego obszaru część.

To co piszesz jest spekulacją i manipulacją, ponieważ:

-nie mamy czego porównać->tu spekulacja

-nie znamy w jakich algorytmów demozaikowania używa każdy z tych producentów, więc nie możemy przyjąć, że stosują takie samo oprogramowanie, a tylko wtedy możemy mówić o wpływie rozdzielczości sensora, na percepcyjnie ostry obraz (sowo klucz :percepcyjnie)->tu manipulacja

Doceniam Twoje zaangażowanie w formułowanie ciekawych kwestii, ale odpowiedzi na nie, są już w zasadzie znane

Zastanawiam się, jak daleko upośledzeni muszą być zawodowi reporterzy, redaktorzy i wydawcy, którzy przez lata dopuszczali do publikacji materiały z matryc o tak niskiej liczbie senseli czerwonych. Przecież mogli za ułamek ceny mieć A7RII. No zupełnie nie rozumiem.

Mam znajomego, który aparatami foto zajmuje się dłużej niż ja. Zawsze kupuje po premierze najnowszy model (dwóch firm, nie Leica - bo to bym jeszcze rozumiał) i wylicza o ile nowszy model ma lepsze ISO, lepszą dynamikę, mniejszy rolling shutter itp. Przez ponad dwadzieścia lat słucham o tych wyższościach nowszego nad starszym, nie wspominając o tyradach dotyczących wyższości jego aparatów (marek) nad wszystkimi innymi. Wszyscy którzy uważają inaczej, nie mają racji. Przez te wszystkie lata zrobił chyba więcej zdjęć "tablic pomiarowych" niż normalnych zdjęć. Oczywiście nigdy nie zgodzi się na ślepy test zdjęć na papierze, bo ... tu miliony powodów, od fałszywych kolorów drukarek, poprzez zły papier, na pogodzie, świetle i wilgotności kończąc. Podsumowując - optyczne policzą i wyliczą tabelki i cyferki, a ja zobaczę zdjęcia z tego "kiepskiego" R3 to sam ocenię, czy mi się podoba, czy nie. W konsekwencji kupię lub nie (wiadomo, że nie, bo czekam na R1:)

Kyle16 września 2021, 22:14

ps. to co wstawiłem:

link

to jest nieskalowany wycinek zdjęcia, a nie jakieś zeskalowane w dół miniaturki, które wstawia baron13 i się dziwi, że nic nie widzi z artefaktów o których piszę.

------------------------

link

link

to kwestia skali odwzorowania - graniczna wynika z rozdzielczosci powierzchniowej matrycy.

jesli zostanie ona przekroczona nie moze detal w ogole zostac odwzorowany prawidlowo - nie tylko kolor ale i forma ulegnie jakiemus tam znieksztalceniu..

pisalem o tym przy okazji dyskusji o rozdzielczosci komorek

rozdzielczosc obrazowania matrycy jest ok 4 razy mniejsza od liczby jej pixeli i tego nie zmienimy - Mowi o tym teoria Nyquista - Kotelnikova - Shannona.

( do prawidlowego odwzorowania 1 punktu obrazu przestrzennego potrzebujemy 4 sensele matrycy )

to nie jest problem rozdzielczosci kolorystycznej ( czyli tonalnej na 3 kanalach ) a problem rozdzielcziosci przestrzennej ( niezaleznie od koloru). Tego sie nie przeskoczy . kazda matryca ma swoje granice. Matryce 24mpx maja granice rozdzielczosci nizszej niz np 48 mpx.

czy to malo czy duzo?

do zastosowan dla jakich przeznaczony jest ten aparat czyli glownie reportaz jest to wystarczajaco.

Dokladne Reprodukcje techniczne , gdzie wymagana jest rzeczywiscie duza wiernosc i zachowana drobiazgowosc odwzorowania i tak nie robi sie aparatami FF - sa za malo rozdzielcze , potrzeba wiekszego formatu matrycy i wiekszej rozdzielczosci obrazowania.

przyklad sfotografowany w skali ok 1:50.

przy skali np 1:100 pojawia sie z cala pewnoscia znieksztalcenia - byloby to dla tego motywu ( grubosc kreski 1 mm ) powyzej zdolnosci rozdzielczej matrycy , kreska nie moglaby zosatac prawidlowo odwzorowana.

@molon_labe

>To co piszesz jest spekulacją i manipulacją, ponieważ:

>-nie mamy czego porównać->tu spekulacja

Na optyczne.pl masz test Sony A7S i Sony A7R. Na zdjęciach testowych które wykonała redakcja, tej powtarzalnej, niezmiennej sceny, widać jak poziom zniekształceń się zwiększa, wraz ze zmniejszaniem rozdzielczości matrycy aparatu:

link

źródło:

link

link

I kto tutaj "spekuluje" i "manipuluje" ? Hę? Ty manipulujesz i spekulujesz, sugerując, że problemu nie ma.

@Pokoradlasztuki

>do zastosowan dla jakich przeznaczony jest ten aparat

> czyli glownie reportaz jest to wystarczajaco.

Biorąc pod uwagę, że takie zdjęcia znajdą się raczej na niższej jakości materiałach (gazeta niższej klasy jakościowej) to pewnie tak. Z drugiej strony, czy nie dałoby się taniej wyprodukować aparatu spełniającego takie niższe wymagania jakościowe? Z trzeciej strony możliwości "filmowe", tego modelu oceniam już wysoko (jak się nie będzie przegrzewał po np. godzinie filmowania w 4K @ 59,94 FPS)

@molon_labe

@16 września 2021, 08:43

>Aby przejść z obrazu „wzór Bayera” do obrazu pełnokolorowego, >oprogramowanie aparatu korzysta z algorytmów i tu jest siła firm.

Jak czegoś nie ma, to tego bez zniekształceń programowo nie wyczarujesz. Różne algorytmy demozaikowania testowałem na prawdziwych zdjęciach i każdy się na określonych przypadkach (detalach) wykładał (sam się możesz tym pobawić, bo programy do wywoływania RAW mają taką opcję ... nawet można zobaczyć zapis bez demozaikowania).

Kyle

:)

"...jak poziom zniekształceń się zwiększa, wraz ze zmniejszaniem rozdzielczości matrycy..." To opisał Pokoradlasztuki 17 września 2021, 08:49- wpis wyżej.

Bądź uczciwy, napisałeś:

"Tymczasem Canon EOS R3 za ponad 20 kPLN, będzie miał takie zniekształcenia WIĘKSZE, od SONY A7R II..." i moje stwierdzenia są aktualne.

Kyle17 września 2021, 09:43

@Pokoradlasztuki

>do zastosowan dla jakich przeznaczony jest ten aparat

> czyli glownie reportaz jest to wystarczajaco.

Biorąc pod uwagę, że takie zdjęcia znajdą się raczej na niższej jakości materiałach (gazeta niższej klasy jakościowej) to pewnie tak.

-----------------

zedcydowana wiekszosc zdjec do gazet robione sa dzisiaj tanimi aparatmi , kompaktami jesli nie komorkami. Zreszta zawsze tak bylo , komorki pojawily sie dopiero ostatnio.

1dx jest bardzo chwalony za jakosc obrazowania , choc ma tylko 18 mpx.

zdecydowana wiekszosc tzw ambitnych amatorow korzysta aktualnie z aparatow 24 mpx , pewnie ze wzgledu na cene , gdyby w tej cenie byly aparaty 48 mpx kazdy raczej taki by kupil , ale nikt nie narzeka na za niska rozdzielczosc.

ale 24 mpx matrycy , czyli prawidlowe oddanie ok 6 m realnych punktow obrazowych to jest duzo . wystarcza. ludzie nawet o tym nie wiedza ze ich zdjecie wcale nie sklada sie ze 24 m. punktow lecz z liczby ok 4 razy mniejszej.

to jest aparat do reporterki , gdzie rozdzielczosc nie jest priorytetem. Ta ktora sie uzyskuje jest bardzo dobra.

Zreszta jak wspomnialem - wysoka rozdzielczosc matrycy wymagalaby b. krotkich czasow naswietlenia z reki , a w reporterce potrzebny jest aparat pozwalajacy na dluzsze czasy. Para by szla w gwizdek.

owszem wyzsza rozdzielczosc moznaby rzec to wieksza uniwersalnosc aparatu - ale to nie jest aparat uniwersalny absolutnie do wszystkiego . Jest do repo. Sytuacje kiedy braknie rozdzileczosci beda niezwykle rzadkie . Sytuacje gdzie beda trudne warunki oswietleniowe , czyli wymagany mozliwie niski szum , dluzsze czasy nasw. , konieczne beda krotkie czasy obrobki, transferu beda niemal zawsze wystepowac w tego typie fotografii. Ja nie widze przeszkod by ten aparat stosowac rowniez w fotografii domowej jak kiedys np c5mk3 - w tym samym celu , dla przyjemnosci - jesli kogos stac to prosze bardzo. Konstrukcja tego nie wyklucza.

@molon_labe

@17 września 2021, 10:05

>Bądź uczciwy, napisałeś:

>"Tymczasem Canon EOS R3 za ponad 20 kPLN, będzie miał takie zniekształcenia >WIĘKSZE, od SONY A7R II..." i moje stwierdzenia są aktualne.

... moje powyższe stwierdzenie też jest nadal aktualne :)

@Pokoradlasztuki

@17 września 2021, 10:10

No w takim wypadku OK. Jednak drogo jak na aparat powiedzmy "nieuniwersalny", tylko "stricte do jednego zastosowania". Za takie pieniądze, oczekiwałbym czegoś bardziej "też do studia, z ultra rozdzielczością".

Choć możliwości filmowe tego modelu, już prędzej mają prawo swoje kosztować. Tylko znowu - skoro aparat "nieuniwersalny" to czy nie wciśnięto tak dobrych możliwości filmowania, fotografowi-reporterowi niepotrzebnie?

@Kyle: na przykład porównujesz ze sobą dwa aparaty, poniekad z innej epoki technologicznej i wyciągasz wnioski. To nie mniejsza rozdzielczość matrycy zdegradowała obraz, ale i poziom szumów i dynamika i prawdopodobnie optyka.

Nie bardzo wiesz, o co tu chodzi?

Nie na darmo zadalem pytanie: jaką mianowicie chcesz udowodnić tezę? I nie na darmo sugeruję, że jak ją sformułujesz, to zabrzmi głupio. Otóż jeszcze jedno: czy mamy w fotografii, ale tej nie polegającej na nieustannych dyskusjach, obracaniu aparatów i tabelek ,ale robieniu zdjęć, które na dodatek mają być do czegoś problem rozdzielczości matryc? Gdybyś np zajmował się fotografią sportową, to wiedziałbyś, że użyteczne materiały mają rozmiary 1024 x 683 piksele. I to jest DUŻO, W fotografii obsługującej portale informacyjne zdjęcia mają zwykle rozmiary nie przekraczające 600 pikseli po dłuższym boku.

Zgroza, że programy do resamplowania w drugą stronę, powiększające je, potrafią z takich miniaturek zrobić materiał np na plakat. Zgroza tym większa, że bywa dość często, że tą drogą gubi się zbędne detale i zdjęcie które przeszło proces zmniejszenia i sztucznego rozmnożenia pikseli wygląda lepiej niż to przeskalowane z oryginalnego pliku. Problemu nie ma. Usiłujesz pokazać, że w jakiś okolicznościach da się to zauważyć. Ale w jakich to nie wiesz i nie pokażesz. Co więcej nie wygląda to tak, że bez wiedzy, czego szukać, zaraz znajdziesz. Nie ma problemu wielkości liczonej w megapikselach matrycy w fotografii nie ma. Wiele razy oddawałem zdjęcia do druku, na wystawy, 3000x2000 to było maks, zawsze wystarczyło, choć wydruki były po 120 cm po dłuższym boku. Problem zawsze jest jeden i on jest zasadniczy: CO JEST NA ZDJĘCIU. Zaś cala technologia w fotografii obraca się naprawdę wokół tego, żeby się dało to coś pstryknąć. Masz miliony genialnych technicznie zdjęć i nic kompletnie nie wartych, a te ze setki tysięcy dolarów czy ojro zwykle są pod względem parametrów technicznych takie sobie.

Tym bardzie bijesz pianę, ponieważ dokładnie ten sam problem występuje w każdym współczesnym urządzeniu. Możemy sobie opowiadać, że 24 megapiksele to mało, ale nic z tego nie wynika, bo to i tak prawie najwięcej, z tego co jest dostępne. Spróbuj sformułować tezę której bronisz, bo na razie to gadasz rzeczy mówiąc prawdę obojętne...

@baron13

>W fotografii obsługującej portale informacyjne

> zdjęcia mają zwykle rozmiary nie przekraczające

> 600 pikseli po dłuższym boku

... bo te portale JESZCZE nie są przystosowane do wyświetlania na ekranach HiDPI.

> Wiele razy oddawałem zdjęcia do druku, na wystawy,

> 3000x2000 to było maks, zawsze wystarczyło,

>choć wydruki były po 120 cm po dłuższym boku.

Zależy jakie kto ma wymagania jakościowe.

> Problem zawsze jest jeden i on jest zasadniczy: CO JEST NA ZDJĘCIU.

Jest też drugi "problem": poza tym co jest na zdjęciu, znaczenie ma (przynajmniej dla mnie) jak wysokiej jakości jest to zdjęcie. Skoro uważasz, że liczy się tylko co jest na zdjęciu, to po co Ci lustrzanka/bezlusterkowiec, skoro przeciętny telefon powinien oblecieć, lub jakiś tandetny kompakt ;)

Chyba najwyzszy czas by pojawil sie "podpis cyfrowy" bo fotografia zniknie, mi zdjecie sportowe, dokumentalne, i wiele innych typow powinno byc wierne.

Tak sobie wyobrazam fotografie, inaczej ja to sobie okreslamy wyrazem "malarstwo", bez ujmowania maalarstwu, po prostu rozdzielczosc pedzla jest inna niz blony/matrycy.

W chwili obecnej uwazam jestesmy w miejscu gdzie AI jest w stanie zapewnic dane fikcyjne nierozroznialne od rzeczywistych, przez co pakowanie kasy w robienie dokumentacji jest bezsensowne, skoro wystarczy 30% by to uroslo do 100% i zwykly odbiorca niezauwazy badz tez bedzie preferowal sztuczne dane bo sa standardowe, normalne, przyjemne, itp.

I to uwazam bedzie koniec fotografii PRO.

Bo po co wydawac pieniadze na sprzet, zawodowca skoro pogladowa miniaturka wystarczy by uzyskac zadowalajacy efekt koncowy.

Z drugiej strony to ciesze sie ze zyje w takich czasach, SF i bioniczni ludzie sa tak blisko.

Moze jeszcze dozyje by sobie cos wszczepic :D

@Kyle: jeszcze raz, sformułuj tezę, której chcesz bronić. Zaś o pomysłach pakowania w urządzenia do komunikacji coraz to bardziej wymagajacej technologii mogę powiedzieć, że już mamy doświadczenia, jak to NIE działa. Praktycznie zniknęła technologia Hi-Fi. Dziś jest tylko jej parodia. w tiwi bynajmniej nikt nie produkuje programów informacyjnych w bogi wiedzą jakich technologiach, choć można. Na przykład programy informacyjne są emitowane nawet bez dźwięku stereo, choć dziś to minimalnie zwiększyło by szerokość pasma przenoszenia, praktycznie niezauważalnie. Nikt się nie bawi w to, co nie przynosi wzrostu oglądalności czy bardzo dobrze w necie mierzalnej "klikalności". Tnie się bezlitośnie koszty. A także wszystko, co tej klikalności nie służy. Dlatego nie ładuje się na strony zdjęć w dużej rozdzielczości, tylko w najmniejszej, przy której publiczność jeszcze nie wali pomidorami w tfurców. Ludziom, którzy nie widzieli podobnych procesów i ich upadku wydaje się, że rozwój technologii będzie szedł w jakimś kierunku do nieskończoności. A on się zatrzymuje w miejscu w którym jeszcze można wiele poprawić jak ów dźwięk stereo w programach tiwi, ale to już nie przynosi wyraźnych zysków.

co technicznej jakości zdjęć, to powiem tyle, ok, kup se aparat :-)

@Kyle: megapixeloza zabija fotografię. i video też. może nawet bardziej. tylko dlatego, że ludzie podniecają się na naklejkę na pudełku z napisem 100MEGAPOIXELI. Branża ślepo tym tropem , i innymi bzdurami, podąża i mamy to co mamy. Katastrofę i zapaść.

Podobnie było w audio. Ci sami znawcy tematu, jak ty, opowiadali bajki o watach mocy, innych parametrach, kiedy to już 7x 150W dla pokoiku 3x4m było minimum, próbkowania w gigaherzach, kable optyczne.... I mamy to co mamy.

Nakręcanie głupoty dotyczącej parametrów sprzętu jest dźwignią handlu. Ale nie w tym segmencie rynku foto video. Chociaż, oczywiście działa, nikt nie jest mądrzejszy od najlepszych marketingowców.

Wiem, że ludzi boli i uwiera patrzeć na produkty typu 1D czy D3. Patrzeć na ich ceny i krytykować sens.

" Ja mam 108MEGAPIXELI w komórce! za pińcet złotych."

Cena jednego korpusu aparatu reporterskiego jest niemiarodajną informacją o koszcie "wejścia " w ten biznes. Może dlatego Sony ciągle jest gdzieś w polu za Canonem i Nikonem, z uporem maniaka wciskając te swoje zabawki jako PROFESJONALNE aparaty. Olek i Fuji też próbowało. To jest żałosne i po prostu kłamliwe, wyłudzanie pieniędzy od naiwnych.

Ale w branży pro foto video, nikt już nie jest naiwny. Rewolucja digital pozamiatała. Popadały agencje. Popadały stare fotolaby. Równocześnie rozwinęło się tworzenie treści do Netu. To jest ostatnie miejsce, gdzie jakość koloru ma znaczenie. Raczej od samego początku chodzi o takie tworzenie obrazu, aby zniekształcenia na tysiącach różnych monitorów były niekrytyczne.

Moim zdaniem w 2021r sens istnienia aparatu typu Canon R1 jest żaden.

Aparaty foto od dekady, od czasów D800 i 5D3, dają sobie doskonale radę.

Dla agencyjnych/sportowych zastosowań R3 to bajka. Dla normalnych ludzi jest absolutnie niepotrzebny. Jak cała masa sprzętu dla PRO, który traci totalnie sens w zastosowaniach półpro, a jest zwyczajnie karykaturą dla amatora.

@DonYoorando: "Może dlatego Sony ciągle jest gdzieś w polu za Canonem i Nikonem, z uporem maniaka wciskając te swoje zabawki jako PROFESJONALNE aparaty." - możesz rozwinąć tę frapującą myśl?

@DonYoorando

@17 września 2021, 14:52

Ale masz pianotok z tym ściekiem który napisałeś :) "108 megapikseli za 500zł" - co za brednie.

"Ci sami znawcy tematu, jak ty, opowiadali bajki o watach mocy, innych parametrach, kiedy to już 7x 150W" - ale ty bzdury mały człowieczku wypisujesz.

@baron13

No tak, zapomniałem, że świat jakości foto, się kończy na zdjęciach w serwisach internetowych z wiadomościami, więc nic lepszego jakościowo nie potrzeba x-P I to pisze osoba, która uważa, że na plakacie nie rozróżnię zdjęcia jakiejś śmiesznej rozdzielczości (ile to było? 1,5 Mpix czy mniej?), od wysokiej jakości zdjęcia kilkadziesiąt Mpix. Teraz Ja powiem coś Tobie: nie oceniaj innych swoją miarą :) I jeszcze jedno Ci powiem: miłego wieczoru. :)

@Szabla. od czasów pierwszego A9 czyli 4lat, może warto by było powiedzieć od czasów A900 , wtedy od 13lat, sony aktywnie atakuje segment pro. Z całą swoją potęgą marketingu. I technologią sensorów. I współpracą z zeissami. I raczej bierną postawą innych producentów. Pomimo to nadal nie widać rezultatów. Jest ewidentnie papierowym tygrysem. Co innego produkować co rok po 5 odsłon, chwała im za to, aparatów dla zaawansowanych fotografów, co innego stworzyć ekosystem dla pro. Czy to ma sens finansowy, czy tylko prestiżowy? nie wiem. Ostatnie kroki sony związane z wyłącznością na ich sprzęt u podupadających agencji widzę jako chęć spróbowania na serio.

Od czasu superduper profesjonalnego A900 minęło 13 lat. System sony jest popularny ale jego expansja idzie "od dołu" , nie od góry. I bardzo dobrze.

Zwyczajnie robią dobre aparaty, za niekoszmarne pieniądze.

Modele topowe, obwoływane objawieniem, co premiera, są raczej ciekawostką i lepem na muchy, takie jak Kyle.

@DonYoorando

>Modele topowe, obwoływane objawieniem, co premiera,

> są raczej ciekawostką i lepem na muchy, takie jak Kyle.

Tak? Aha. No nie wiedziałem, bo jakoś zupełnie się ich "topowymi" aparatami nie interesowałem, tylko właśnie stosunkowo tanimi pełnymi klatkami "dla ludu" z serii A7. Innymi słowy, znowu coś wymyślasz.

@Szabla: moja spiskowa teoria dotycząca nieobecności sony w segmencie pro? to by zabiło nikona. jest im korzystniej skubać canona, zarabiać na sensorach w aparatach innych marek, czekać na rozwój wypadków. działa jak zaklęcie dobrej wróżki.

Wracając do R3, obecnie nie ma porównywalnego aparatu na rynku. To nie świadczy o niezaradności sony. O słabości nikona, tak.

@DonYoorando: na pewno informacja, że około 30% fotografów na igrzyskach w Tokio używało Sony nie będzie istotna? No i Associated Press jako upadająca agencja... Porównywalnego nie ma, ale jest lepszy czyli A1. :)

Próbowałem nawet wziąć udział w tej dyskusji, napisałem post - z pewnym poparciem dla *barona13*, ale go "wcięło". Ciekawostka, choćby w kwestii, dość ważnej, tzw. "wolności słowa" - to forum jest ponoć publiczne. Fakt, zbanowali mnie tu, ale ponoć na pół roku i już od jakich 3 kwartałów powinienem być "akceptowalny", a tu widać problemy.

Ciekawe, co z tym postem będzie? może to jednak w rzeczywistości jest jednak prywatne forum? fanów fufu? a ja w końcu chyba jestem raczej fanem m4/3 (w każdym razie na tym formacie jakoś się zatrzymałem, postępując od 1/1,7")

O! jednak poszło! ale tamten zaginiony post był większy; dodam tylko, że w kwestii "kolorystycznej" rozdzielczości pikselów matrycy tego Cwanona, to ona chyba wynosi tyle ile producent podaje: 24 Mpx, bo przecież filtr Bayera tylko nieco osłabia sygnał na każdym "senselu" (dając w zamian informację kolorystyczną); to z grubsza różnica między takim aparatem, jak ten Cwanon i Leiką Monochrom (to takie rozważanie "na chłopski rozum", of course).

W każdym razie ten R3 to bez wątpienia świetny przyrząd fotograficzny, tylko nie dla każdego z pewnością. Ja tam chyba pozostanę jednak przy Olympusie Pen. Może co najwyżej kupię kiedyś, jak nastąpi jakiś lepszy czas, jakiegoś OMD (albo wg nowej terminologii: OM, xxD - jednak celownik czasem się przydaje).

Tym niemniej miło o Canonie R3 podyskutować.

> No i Associated Press jako upadająca agencja...

zdaje się,ze także jacyś wyspiarze europejscy zajmujący się reporterką też wybrali Soniego. Cóż, czasy się zmieniają i firmy foto wraz z nimi.

@JdG

@17 września 2021, 21:57

>w kwestii "kolorystycznej" rozdzielczości pikselów matrycy

> tego Cwanona, to ona chyba wynosi tyle ile producent podaje:

> 24 Mpx, bo przecież filtr Bayera tylko nieco osłabia sygnał

> na każdym "senselu"

Budowa 24 megapikselowej matrycy jest taka, że jest 24 miliony "kwadracików"/fotodiod, a nad każdą z tych 24 milionów fotodiod, jest filtr barwny (a'la jak te okulary 3D dodawane do gazet), jednak ten filtr nad pojedynczą fotodiodą ma tylko jeden kolor: albo zielony, albo czerwony, albo niebieski (są jeszcze matryce mające zamiast zielonego filtr żółty).

NIE jest tak, że nad każdą fotodiodą, jest kompletny zestaw filtrów R+G+B.

Podsumowując, ten aparat sprzedawany jako 24 megapikselowy, ma tak na prawdę 6 milionów "kropek"/"pikseli"/"senseli" czerwonych, 6 milionów niebieskich i 12 milionów zielonych.

W monitorach liczy się to bardziej uczciwie: jeden piksel, to pełna informacja o kolorze (w sensie ma wszystkie 3 kanały koloru: zielony, czerwony i niebieski).

> Budowa 24 megapikselowej matrycy jest taka, że jest 24 miliony "kwadracików"/fotodiod, a nad każdą z tych 24 milionów fotodiod, jest filtr barwny

nie musisz mi tłumaczyć jak działa matryca, z grubsza wiem; matryca CMOS odczytuje, konwertuje i zapisuje sygnał z każdego swojego piksela oddzielnie, to jest w konsekwencji przełożony na cyferki prąd, jaki się w takim pikselu pod wpływem światła wzbudził. Filtr barwny modyfikuje ten sygnał na wejściu (jak to filtr, odcina część widma) i ta modyfikacja jest właśnie informacją o kolorze; innej chyba nie ma (AFAIK).

Oczywiście potem już nie jest tak prosto, bo komputer dopiero buduje z tego obraz, musi ustalić wartość każdego jego punktu w skali szarości, co jest raczej proste, i dodatkowo ustalić jego kolor, co wymaga analizy informacji z sąsiednich pikseli, jednak dotyczy to każdego piksela matrycy.

Sytuacja, że algorytm demozaikowania musi skorzystać z informacji z minimum 4 sąsiednich pikseli (AFAIK) nic tu przecież nie zmienia, choć oczywiście jest to pewna interpolacja informacji. Muszę pozostać na takim poziomie ogólności, bo nigdy nie zajmowałem się konstrukcją matryc i procesorów obrazowych.

Istnieją, z tego co wiem, matryce, które potrafią analizować pełną informację o kolorze w każdym pikselu (zdaje się, że Sigma takie czasem produkuje), ale jakoś nie zdobyły one szerszego zastosowania. O ile pamietam, to takie urządzenie świetnie się sprawdza tylko w nominalnej czułości, natomiast filtr Bayera zadziała w każdej, jaką maszyna zdoła rejestrować. Może stąd jego przewaga. Widać ta interpolacja jest wystarczająco dobra, co zresztą potwierdzają fotografie, które tutaj każdemu pewnie zdarza się robić.

kryteria wyboru sprzętu przez agencje są trochę bardziej skomplikowane, niż to który aparat ma więcej kółek i więcej MEGAPIXELI. cieszy, że po dekadach duopolu pojawia się sony i to z aparatami z innej, niższej ligi.

jeżeli ktoś, tak jak ja, śledzi premiery topowych cyfrowych puszek, to wie , że i olympus był wybierany masowo przez profesjonalistów do najtrudniejszych zadań, i panasonic był niezrównany i pentax miał profesjonalną, ogromną rzeszę fotoreporterów z białymi lufami i oczywiście mój ulubiony statek kosmiczny fotografii reportersko sportowej FUJI.

fajnie, że się coś dzieje, fajnie, że przez ostatnie 10lat produkcja sprzętu foto zmalała o 90 kilka %. to daje starym zgredom, takim jak ja, pożywkę do obśmiewania tych rewolucyjnych nowości i prawd objawionych o sensorach, rozdzielczościach kolorów, wyborach profesjonalistów i całej reszcie tego tortu, przepraszam, torciku...

DonYoorando

"jeżeli ktoś, tak jak ja, śledzi premiery topowych cyfrowych puszek, to wie , że i olympus był wybierany masowo przez profesjonalistów do najtrudniejszych zadań, i panasonic był niezrównany i pentax miał profesjonalną, ogromną rzeszę fotoreporterów"

Powinno być:

Olympus był wybierany masowo przez dwóch profesjonalistów do najtrudniejszych zadań.

Pentax miał profesjonalną, ogromną rzeszę fotoreporterów 40 - 50 lat temu.

Problem tej dyskusji jest taki, że przynajmniej cześć też Kyle jest i owszem prawdziwa, ale całkowicie obojętna. Gdyby istniała technologia alternatywna do Bayera,lepsza, to... pewnie wszyscy by na nią przeszli. I dalej nie było by sprawy. Mamy taką technologię jaką mamy. Można jej przypisać wady. Ale i takjest najlepsza. Do tego ma parametry, które dają wystarczające rezultaty. Posiadam aparaty od Eosa 450d od matrycy 12 megapikseli i widzę, że nie upakowanie jest problemem. Istotne parametry to szumy dynamika i maksymalna czułość. To one określają, co można urządzeniem sfocić, a czego nie można. To jest powód, że mamy charakterystyczną "telefoniczną" tematykę, związaną także ze sposobem celowania ze smartfona. To jest także powodem, że matryc aparatów nie upakowano bez pamięci. Bo diabli wezmą realną dynamikę skoczą szumy, a że nic się nie zyskuje to widać.

Nie ma tezy w tej dyskusji. Kyle zapewne chciałby przekonać, że wobec jego odkrycia to telefony są... nie gorsze. Ale nie są. Co widać po zdjęciach.

Miało być "... cześć TEZ". :-)

@baron13

>Gdyby istniała technologia alternatywna do Bayera,lepsza, to...

>pewnie wszyscy by na nią przeszli.

Jestem ciekaw, jak by wyglądało zdjęcie, gdyby każdy piksel na matrycy światło-czułej miał pełną informację o kolorze, czyli składał się z trzech sub-pikseli. Nie mówię tutaj nawet o Foveon, gdzie docieranie do głębszych warstw generuje nowe problemy, ale o takiej budowie pojedynczego piksela (NIE warstwowej, jeśli chodzi o ułożenie filtrów):

link

Kyle18 września 2021, 09:45

@baron13

>Gdyby istniała technologia alternatywna do Bayera,lepsza, to...

>pewnie wszyscy by na nią przeszli.

Jestem ciekaw, jak by wyglądało zdjęcie, gdyby każdy piksel na matrycy światło-czułej miał pełną informację o kolorze, czyli składał się z trzech sub-pikseli.

--------------------

kazdy subpixel otrzymalby 1/3 swiatla calosci , czyli dokladnie tak jakl teraz caly pixel pod filtem otzymuje 1/3 swiatla ( mowa o swietle bialym)