Fujifilm X-T50 - test trybu filmowego

Komentarz można dodać po zalogowaniu.

Zaloguj się. Jeżeli nie posiadasz jeszcze konta zarejestruj się.

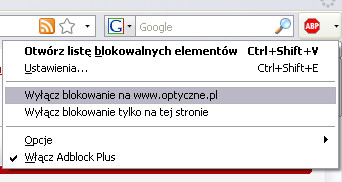

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Będziemy wdzięczni, jeśli dodasz stronę Optyczne.pl do wyjątków w filtrze blokującym reklamy.

Z góry dziękujemy za zrozumienie.

Kliknij tutaj aby zamknąć to okno.

Komunikat nie wyświetli się więcej podczas tej sesji (wymagana obsługa cookies).

Amadi: "W trybie 4K z wykorzystaniem całej szerokości matrycy stosowana jest z kolei jakaś forma pomijania linii lub grupowania pikseli, bo w obrazie pojawia się sporo aliasingu."

Może dlatego, że to matryca X-Trans 5 HR?

Generalnie tak – powodem jest 40-megapikselowy i niezbyt szybki sensor.

Nawiązując do końcówki wczorajszych "Pogadanek o filmowaniu i sprzęcie filmującym #75"

- "FX2: 33MP sensor of the Sony A7IV" link

OJP!

-Nic dziwnego, że nawet SAR zauważa, że link

Aparat jak aparat, ale teraz nawet niższa półka filmuje z próbkowaniem 4.2.2 10bit, a jak nie było tak nie ma kart graficznych PC obsługujących ten format. Albo hiper drogie NVIDIA, albo procesorowy Intela dekoder. Dla procesorów AMD pozostaje dekodowanie programowe. Nie rozumiem tego, skoro to jest obecnie bardzo popularny format zapisu, a NVIDIA pozwala dekodować sprzętowo np 4.4.4 10bit czy nawet 12bit... Oczywiście piszę o h265.

Myślę, że może to kwestia braku przepływu informacji między producentami aparatów i osobami, które nimi filmują, a producentami kart graficznych. Zresztą w porównaniu do graczy, kopaczy kryptowalut, czy ludzi bawiących się AI, to podejrzewam, że jesteśmy zbyt małą niszą, żeby ich obchodzić.

Ale nisza jest chyba większa, jeśli uwzględni się videostreaming (czyli wszystkie te YT, Netfliksy, Disneye i inne VOD-y)?

Pytanie ile streamingu leci w H.265 4:2:2 / 10-bit. Obstawiam, że jest to ilość w granicach błędu statystycznego. Popularne formaty są akcelerowane – link

Ano tak. Jeśli więc to wygląda podobnie na Makówkach i na telefonach, to po co się wysilać - skoro i tak prawie nikt tego nie będzie miał sposobności zobaczyć?

Kodeki typu H.265 4:2:2 / 10-bit nie są po to, żeby w nich filmy renderować i potem wyświetlać. Są po to, żeby filmowiec miał zapas informacji i mógł robić bardziej zaawansowaną korekcję koloru czy np. lokalnie korygować ekspozycję. Na tej samej zasadzie zdjęcia się robi w 14-bitowych RAW-ach, a wyświetla w 8-bitowych JPEG-ach.

A, rozumiem, czyli to taka jeszcze akceptowalna forma nie-RAW-ów.

Dokładnie. 10-bitowy kodek i profil logarytmiczny to najbliżej RAW-a jak się da bez faktycznego używania RAW-ów. I nadal pliki są mniejsze, nawet w porównaniu z mocno skompresowanymi RAW-ami.

Ciekawe co skłoniło redakcję do wykonania testu trybu filmowego korpusu, który raczej jest przeznaczony dla fotografów (test to w mojej ocenie potwierdza). Jego ekran LCD odchyla się tylko góra-dół, co jest duzżym ograniczeniem np. dla vlogerów.

Chętnie zobaczę test trybu foto tego korpusu, który wydaje się być niezłą propozycją nie tylko dla wymagającycg fotoamatorów, ale jako drugiego korpusu dla profi.

Sprawa jest prosta – jak już coś trafia do redakcji, to robione są oba testy. Chyba że jest to aparat pozbawiony trybu filmowego albo kamera bez trybu foto.

@Bahrd

Raczej jest zupełnie odwrotnie. Serwisy streamingowe, podobnie jak stacje telewizyjne czy platformy (satelitarne lub kablowe) raczej obniżają jakość, bo to oznacza przede wszystkim mniejsze zapotrzebowanie na przepustowość (w sieciach i transponderach satelitarnych). Te oszczędności pozwalają korzystać z tych usług na telefonach gdzie prędkość połączenia nie jest stała i stabilna, nawet gdy deklarowana jest duża. Wiele stacji TV to przepływności strumienia to tylko ok 4Mbity - dla porównania strumień 8K w Canonie R5 to nawet 2600Mbitów (4K - 960Mbitów). Tym usługodawcom wcale nie zależy na tym aby Twój odbiornik miał super możliwości. Dodatkowo mogą chcieć więcej kasy za podwyższenie jakości - proste.

@Amadi

4.4.4 12bit jest popularny? Raczej stosuje się Rawy lub Apple prores itp.

Deel, ja to rozumiem, a nawet się zgadzam.

Tym niemniej spójrzmy na tak: zejście z 4:4:4 12bit na 4:2:0 8bit to redukcja z 12*(4+4+4) = 144 bitów do 8 * 6 = 48 bitów, czyli marne 3x. A mówimy o kompresja na poziomie trzech rzędów wielkości (z gigabitów na megabity), więc ta istotna różnica osiągana jest innymi sposobami.

Mnie to specjalnie nie robi jak raz różnicy - dopóki piłka w locie do kosza nie pojawia się i znika co chwilę - w zależności np. od tego jak bardzo jest podobna do tła przez które przelatuje (ale to na pewno nie z powodu obcięcia liczby bitów)! ;)

@Maciox - 4:4:4 / 12-bit praktycznie nie występuje. Przy nagrywaniu powyżej 4:2:2 / 10-bit raczej już się przechodzi na RAW-y. A w postprodukcji przy przenoszeniu projektu np. na efekty specjalne krążą nieskompresowane sekwencje TIFF-ów albo innych klatek.

Z ciekawostek to Canon C300 Mark II miał tryb nagrywania Full HD 4:4:4 / 12-bit. W Mk III chyba z tego zrezygnowali, ale głowy sobie obciąć nie dam.

@Amadi

No właśnie, a dekodowanie sprzętowe jest dla 4:4:4 12bit.

I tu wracamy do tego, o czym pisałem na początku, czyli ewidentnie szwankującej komunikacji między producentami sprzętu filmowego i filmowcami a producentami kart graficznych.

Jedni i drudzy uważają, że tamtych nie ma. ;)

Dobre, Szabla :)